RoBERTa(論文の詳細② Experimental Setup)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #15

言語処理へのDeepLearningの導入をご紹介するにあたって、#3〜#8においては、Transformer[2017]やBERT[2018]について、#9~#10ではXLNet[2019]について、#11~#12ではTransformer-XL[2019]について取り扱ってきました。

XLNet②(事前学習におけるAutoRegressiveとPermutation)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #10 - lib-arts’s diary

Transformer-XL(論文のAbstractの確認)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #12 - lib-arts’s diary

#13以降では2019年7月にリリースされたBERTベースでハイパーパラメータ(学習にあたってのlossやデータセット)のチューニングを行なった事前学習モデルであるRoBERTa[2019]について取り扱っていきます。

https://arxiv.org/abs/1907.11692

#13では上記のAbstractをベースにRoBERTa[2019]の概要について、#14ではRoBERTa[2019]の論文のIntroductionとBackgroundについて確認しました。

RoBERTa(論文のAbstractの確認)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #13 - lib-arts’s diary

#15ではRoBERTa[2019]の論文のSection3のExperimental Setupについて確認していきます。

以下目次になります。

1. Experimental Setup(Section3 冒頭)

2. Implementation(Section3.1)

3. Data(Section3.2)

4. Evaluation(Section3.3)

5. まとめ

1. Experimental Setup(Section3 冒頭)

1節ではSection3の冒頭を確認します。上記のように一文のみとなっているので和訳します。

In this section, we describe the experimental setup for our replication study of BERT.

和訳:『このsectionでは、我々のBERTの追加研究の実験的な設定について記述する。』

#14でまとめたSection2のBackgroundにBERTのオーソドックスな情報がまとめてありましたが、それとの対比としてSection3では実験的な設定についてまとめられています。

2節以降で各サブSectionについて確認していきます。

2. Implementation(Section3.1)

2節ではSection3.1のImplementationについて確認していきます。基本的にはBERTの設定を踏襲しているようですが、何点か変更点などについても言及されています。以下、パラグラフ単位で確認していきます。

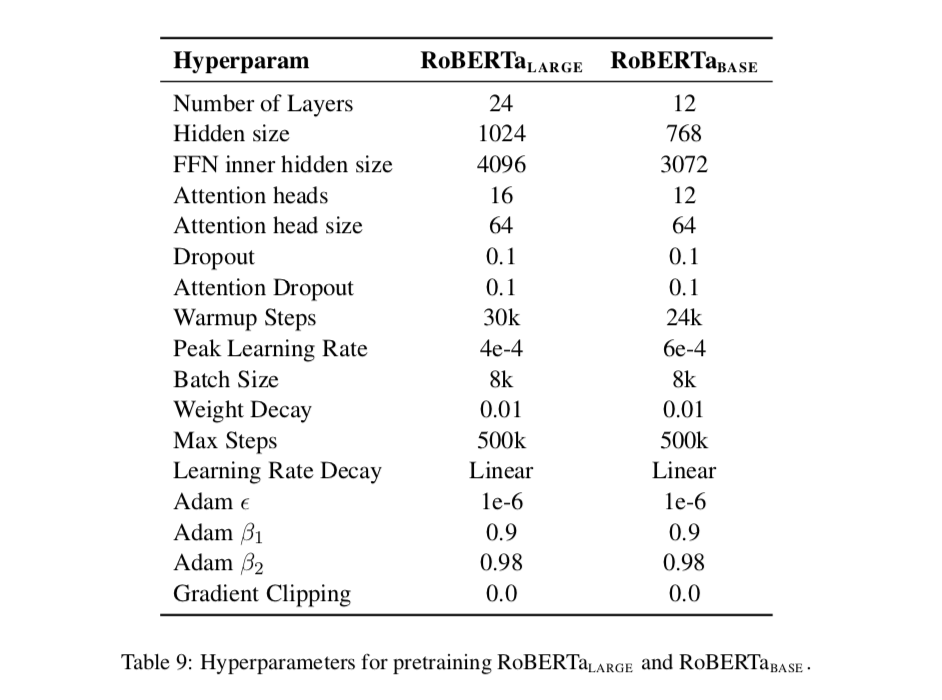

第一パラグラフでは、再実装にあたっては基本的にSection2の最適化の設定を踏襲した一方で、peak learning rateやnumber of warmup stepsは例外としたとあります。また、それに加えて、学習はAdamのepsilon termに影響を受けやすいことがわかり、同様にと設定することで学習の安定性を図ることができるともされています。

第二パラグラフでは、配列のMAXの長さをで設定し、学習データの加工などについて言及されています。

第三パラグラフでは、学習に用いたマシンについてまとまっています。

3. Data(Section3.2)

3節ではSection3.2について見ていきます。パラグラフ単位で見ていきます。

第一バラグラフでは、データセットの規模について論述されています。BERTのような(BERT-styleの)事前学習は、学習に用いる大規模なテキストデータに大きく依存し、Baevski et al. (2019)ではデータサイズを大きくさせることでend-task(ここではfinetuningと考えて良さそう)におけるパフォーマンスを向上させたとされています。しかしながら、全ての追加したデータセットが公開されているわけではないので、可能な限り多くのデータを用意しようとしたとされています。

第二パラグラフでは、実際にデータセットとして5つの英語のコーパスを用意し、160GBを超えるデータセットとしたとされています。

データセットについて以降でまとまっているので、箇条書きの形式でまとめます。

・BOOK CORPUS plus English WIKIPEDIA(16GB)

・CC-NEWS(76GB)

・OPEN WEB TEXT(38GB)

・STORIES(31GB)

上記の合計で160GB超えのデータを用いたとされています。5つのデータセットとあったのは、BOOK CORPUS、English WIKIPEDIA、CC-NEWS、OPEN WEB TEXT、STORIESの5つだと解釈して良いと思われます。

4. Evaluation(Section3.3)

4節ではSection3.3のEvaluationについて見ていきます。GLUE、SQuAD、RACEの3つのデータセットに分けて論述されているので、それぞれのデータセット単位で見ていきます。

・GLUE(The General Language Understanding Evaluation)

まずはGLUEについて見ていきます。

GLUEは、The General Language Understanding Evaluationの略で、汎用的な言語理解を示すベンチマークとして設定されています。第一パラグラフではGLUEについての説明がなされています。第二パラグラフでは、Section4において、事前学習後のモデルをGLUEのタスクでfinetuningした結果について言及されているとされています。結果については学習データ(development sets)結果とされています。学習においてはmulti-taskやensembleを用いないで学習したとあり、また、finetuningの手順はoriginalのBERTの論文を踏襲したとされています。第三パラグラフでは、Section5においてはpublicなleaderboardからテストデータ(test set)での検証を行なったことについて言及されています。

・SQuAD(The Stanford Question Answering Dataset)

次にSQuADについて見ていきます。

SQuADは、The Stanford Question Answering Datasetの略で、Question Answeringを行うにあたってのデータセットです。第一パラグラフではデータセットの概略についてまとまっています。文章(分脈; context)のパラグラフと質問が与えられたデータセットで、文章を読解し、質問に回答するタスクであるとされています。Version1.1とVersion2.0の二つがあるとも言及されています。第二パラグラフでは評価に関してまとめられています。

・RACE(The ReAding Comprehension from Examinations)

最後にRACEについて見ていきます。

RACEはThe ReAding Comprehension from Examinationsの略で、読解(Reading Comprehension)タスクについてのデータセットです。28,000節の文章と約100,000の質問からなる大規模な読解に関するデータセットで、中国の中高の英語の試験からデータセットは作成されています。1つの節の文章に対し、いくつかの質問文があり、その四択問題を解くとされています。RACEはその他のよく用いられている文書読解のデータセットよりも長い分脈の読解が必要とされるタスクとなっているとされています。

5. まとめ

#15ではRoBERTa[2019]の論文のSection3のExperimental Setupについて確認しました。Section3では実装、データセットの概略と、評価に用いるベンチマークの説明が行われていました。

#16ではSection4のTraining Procedure Analysisについて取り扱います。