RoBERTa(論文のAbstractの確認)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #13

言語処理へのDeepLearningの導入をご紹介するにあたって、#3〜#8においては、Transformer[2017]やBERT[2018]について、#9~#10ではXLNet[2019]について、#11~#12ではTransformer-XL[2019]について取り扱ってきました。

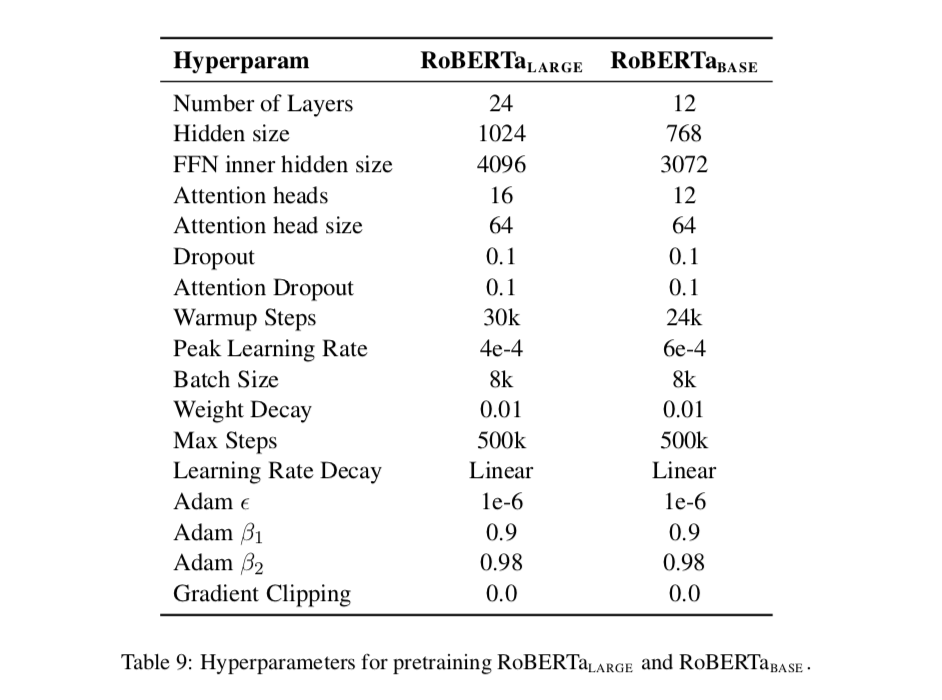

#13以降では2019年7月にリリースされたBERTベースでハイパーパラメータ(学習にあたってのlossやデータセット)のチューニングを行なった事前学習モデルであるRoBERTa[2019]について取り扱います。

[1907.11692] RoBERTa: A Robustly Optimized BERT Pretraining Approach

#13では上記のAbstractをベースにRoBERTa[2019]の概要について確認します。

以下目次になります。

1. RoBERTaの概要の把握(Abstractの把握)

2. まとめ

1. RoBERTaの概要の把握(Abstractの把握)

1節ではRoBERTa(RoBERTa: A Robustly Optimized BERT Pretraining Approach)の概要の把握を行います。概要を掴むにあたっては、論文の重要な点は基本的にAbstractに記載されているのでAbstractを確認していきます。

[1907.11692] RoBERTa: A Robustly Optimized BERT Pretraining Approach

上記を元に1文ずつ和訳と解説を行なっていきます。

Language model pretraining has led to significant performance gains but careful comparison between different approaches is challenging.

和訳:『言語モデルの事前学習は(BERT[2018]やXLNet[2019]などに代表されるように)目覚ましい成果をあげてきたが、異なる手法間の慎重な比較はまだ途中段階である。』

途中補足としてBERT[2018]やXLNet[2019]を挙げましたが、2018年10月のBERTを皮切りに言語処理の事前学習について注目が集まっています。画像認識におけるAlexNet[2012]やVGGNet[2014]、ResNet[2015]時と同様に、事前学習モデルとしてのパフォーマンス向上が目覚ましく起きています。一方で目覚ましい改善が行われている時点においてはどれが良いかというのは言い切れないので、慎重な比較はまだできていないと言及されています。

Training is computationally expensive, often done on private datasets of different sizes, and, as we will show, hyperparameter choices have significant impact on the final results.

和訳:『学習というのは計算機的に高価で、様々なサイズの手持ちのデータでしばしば行われるが、我々が示すようにハイパーパラメータの選択は最終結果において大きな影響を及ぼす。』

BERTやXLNetのサイズは大きく学習コストも大きくかかることや手持ちのデータ(private datasets)で再学習するなどの一般論について言及したのちに、RoBERTaのテーマであるハイパーパラメータの選択について示唆されています。

We present a replication study of BERT pretraining (Devlin et al., 2019) that carefully measures the impact of many key hyperparameters and training data size.

和訳:『我々はBERTによる事前学習の追加研究(replication study)を行なった。追加研究においては多くの重要なハイパーパラメータや学習データのサイズの影響を注意深く測定している。』

that以下は先に訳した方が日本語的には良いですが、必要以上に語順を変えたくなかったので後から訳す形にしました。replication studyはある研究に対して後から取り組む研究のことを指しているようです。また、「ハイパーパラメータや学習データのサイズの影響」を丁寧に測定することで、パフォーマンス測定にあたってのより深い考察を導き出せるようにしています。

We find that BERT was significantly undertrained, and can match or exceed the performance of every model published after it.

和訳:『我々はBERTが顕著に学習不足であることや、BERT以後に発表された全てのモデルのパフォーマンスに並んだり上回ったりすることを発見した。』

undertrainedは学習不足、訓練不足という意味なので、BERT[2018]が訓練不足だったと指摘する内容になっています。発表された当初は大きく注目を浴びたBERTですが、BestかというよりもEpoch Makingだったという点で捉えておくと良さそうです。

Our best model achieves state-of-the-art results on GLUE, RACE and SQuAD.

和訳:『取り組んだ中でベストのモデルはGLUE、RACE、SQuADなどのデータセットにおいてSOTAを達成した。』

GLUE、RACE、SQuADはそれぞれベンチマークとして用いられるデータセットです。それぞれThe General Language Understanding Evaluation(GLUE)、The ReAding Comprehension from Examinations(RACE)、The Stanford Question Answering Dataset(SQuAD)の略となっています。これらのベンチマークでこれまでのSOTAを上回ったとされています。

These results highlight the importance of previously overlooked design choices, and raise questions about the source of recently reported improvements. We release our models and code.

和訳:『以後で取り上げる結果のハイライトでは従来見過ごされたハイパーパラメータやデータセットなどの選択やチューニングの重要性について示し、近年報告されている改善の源泉に関する問題提起を行なっている。当論文を公開するにあたりモデルとコードを公開した。』

モデルやコードに関しては下記で公開されています。

GitHub - pytorch/fairseq: Facebook AI Research Sequence-to-Sequence Toolkit written in Python.

また従来見過ごされた(previously overlooked)に関しては、BERT[2018]からの研究の潮流が期間的に早いというのと、BERT自体がそれまでと比較して大きな成果となったためにまだ検討しきれていない部分が出てきているという認識で良さそうです。

2. まとめ

#13ではRoBERTa(RoBERTa: A Robustly Optimized BERT Pretraining Approach)の概要を掴むにあたって、Abstractの和訳と簡単な補足を行いました。

#14では同じくRoBERTaの詳細について確認していきます(replication studyなので全体を満遍なく確認するのが良さそうです)。