A Decomposable Attention Model for Natural Language Inference②(Related Work以降)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #38

言語処理へのDeepLearningの導入をご紹介するにあたって、#3〜#8においては、Transformer[2017]やBERT[2018]について、#9~#10ではXLNet[2019]について、#11~#12ではTransformer-XL[2019]について、#13~#17ではRoBERTa[2019]について、#18~#20ではWord2Vec[2013]について、#21~#24ではALBERT[2019]について、#26〜#30ではT5[2019]について、#31〜#32ではERNIEについて、#33〜#34ではELMo[2018]について、#35〜#36ではself-attentionについて取り扱ってきました。

XLNet②(事前学習におけるAutoRegressiveとPermutation)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #10 - lib-arts’s diary

ALBERT③(The Elements of ALBERT)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #23 - lib-arts’s diary

#37以降ではDecomposable Attentionを確認するにあたって"

A Decomposable Attention Model for Natural Language Inference"について取り扱います。

[1606.01933] A Decomposable Attention Model for Natural Language Inference

#37ではAbstractとIntroductionの確認を行いました。

#38ではRelated Work以後の内容の重要部分の抜粋を行います。

以下目次になります。

1. Related Work(Section2)

2. Approach(Section3)

3. Computational Complexity(Section4)

4. Experiments(Section5)

5. Conclusion(Section6)

6. まとめ

1. Related Work(Section2)

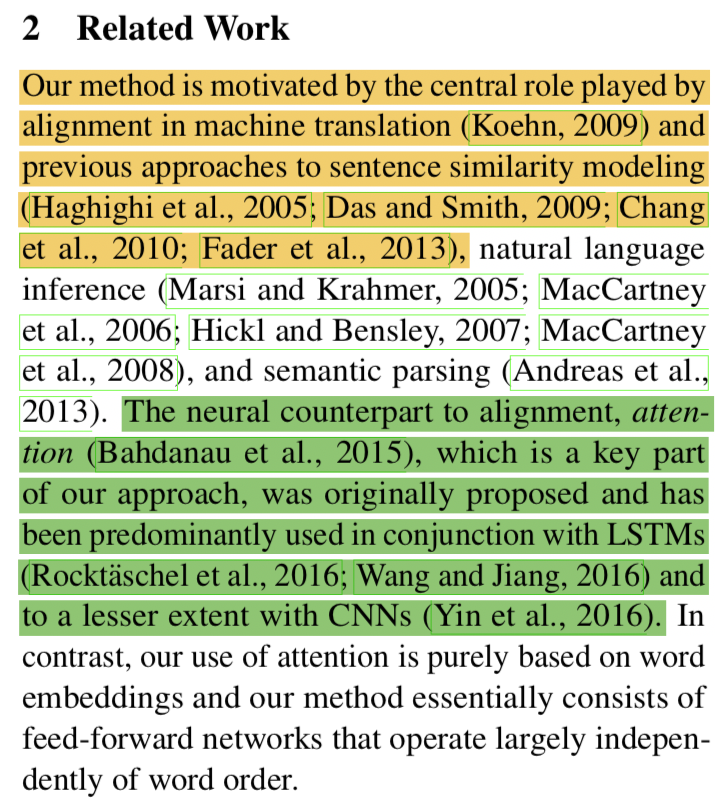

1節ではSection2のRelated Workについて取り扱います。

上記のように関連研究が挙げられていますが、(Bahdanau et al., 2015)とされているのがニューラルネットワークのattentionに関しての初期の研究としてその後の論文から数多く参照されています。従来の研究と対照的に、Decomposable Attention Modelの研究では単語のベクトル表現(word embeddings)を主に用いているとされています。

2. Approach(Section3)

2節ではSection3のApproachについて取り扱います。

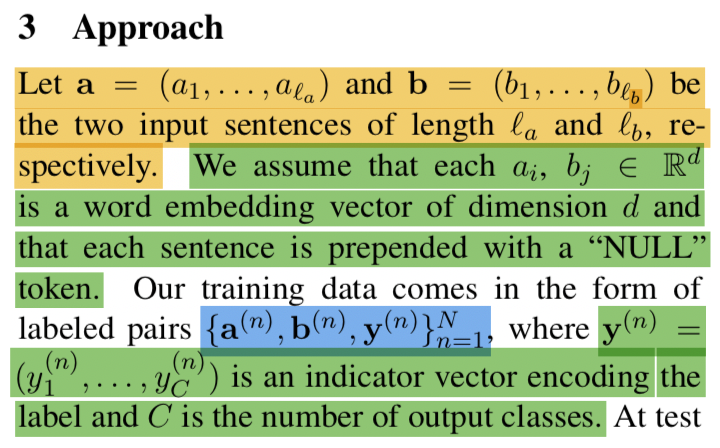

冒頭のパラグラフでは、問題を数式で表現するにあたって、文字の定義を行っています。と

は入力する系列(言語)とし、

と

は次元dの単語のベクトル表現であるとされています。また

はindicator vectorとされており、Cは出力のクラス数であるとされています。

上記ではInput representationについて記述されています。Decomposable Attention Modelの論文で取り扱うvanilla versionではと

はそれぞれ

と

と同様に取り扱うとされているので、記号が変わったことは特に意識しなくて良さそうです。また、Decomposable Attention Modelのコア部分は三つの構成要素からなるとされています。

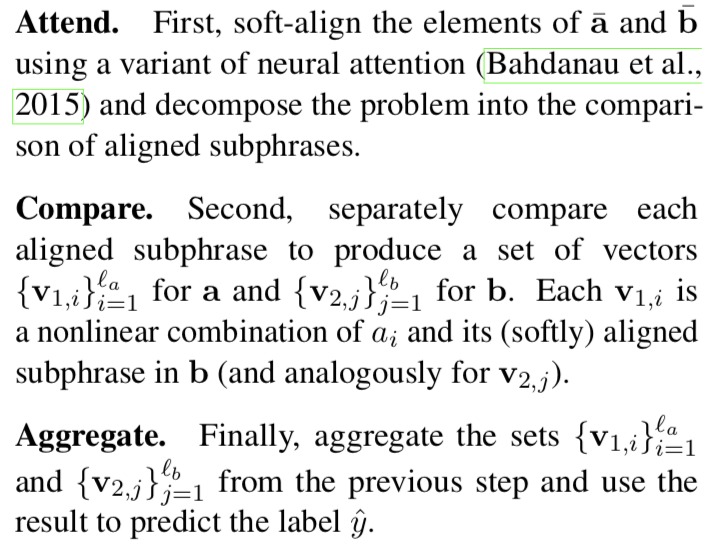

上記ではInput representationの三つの構成要素として、Attend、Compare、Aggregateが紹介されています。

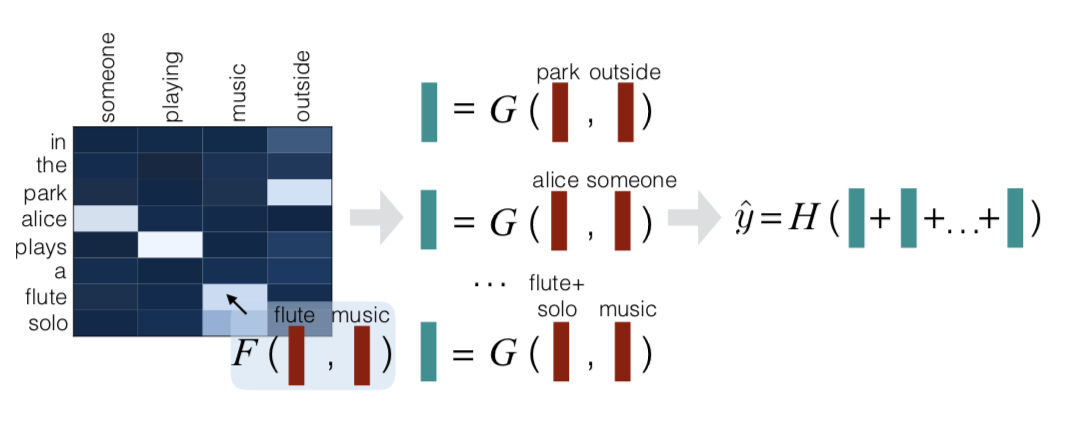

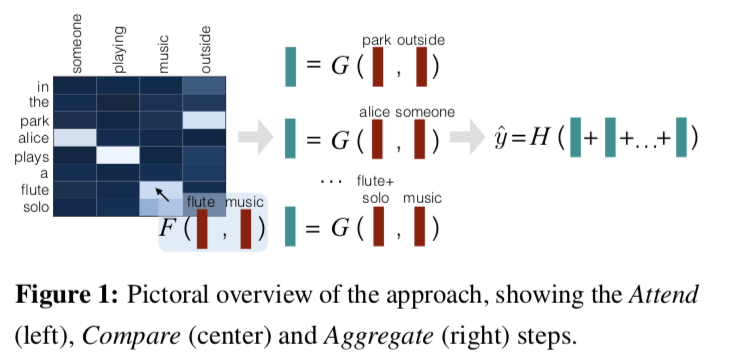

Attend、Compare、AggregateはFigure1で概要が図示されています。Attendが左、Compareが中央、Aggregateが右側を指すとされています。

3. Computational Complexity(Section4)

省略します。

4. Experiments(Section5)

4節ではSection5のExperimentsについて取り扱います。

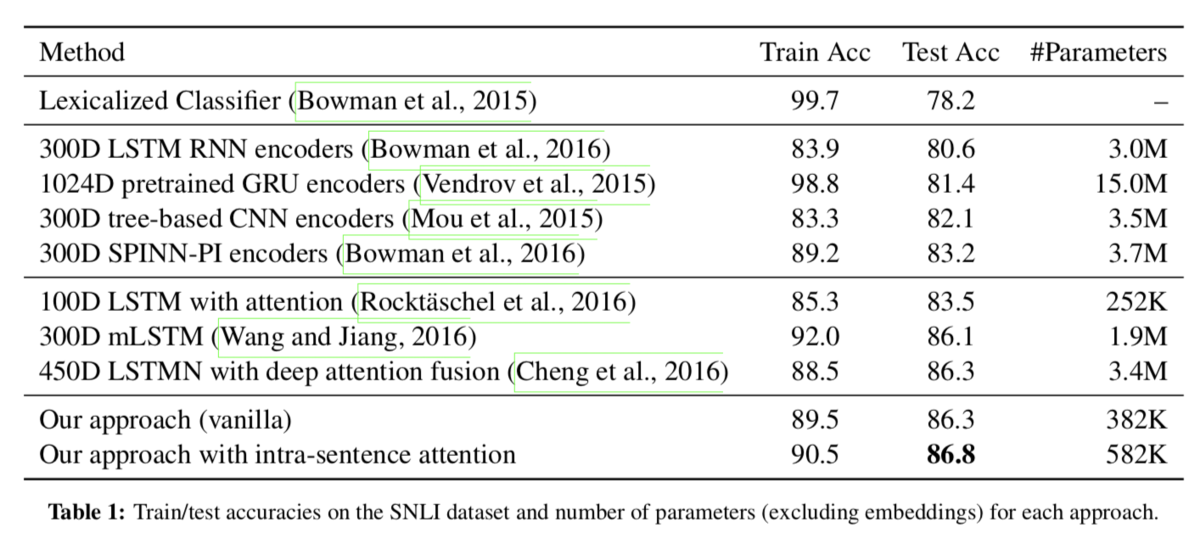

Table1では実験における正答率(accuracy)の比較が行われています。Test Accuracyに置いてこの研究の手法がSotAを実現したとされています。

5. Conclusion(Section6)

省略します。

6. まとめ

#38ではDecomposable Attentionに関する"

A Decomposable Attention Model for Natural Language Inference"のRelated Work以下の内容を確認しました。

#39以降ではTransformerの効率化について取り扱ったReformerについて確認していきます。