A Decomposable Attention Model for Natural Language Inference①(Abstract&Introduction)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #37

言語処理へのDeepLearningの導入をご紹介するにあたって、#3〜#8においては、Transformer[2017]やBERT[2018]について、#9~#10ではXLNet[2019]について、#11~#12ではTransformer-XL[2019]について、#13~#17ではRoBERTa[2019]について、#18~#20ではWord2Vec[2013]について、#21~#24ではALBERT[2019]について、#26〜#30ではT5[2019]について、#31〜#32ではERNIEについて、#33〜#34ではELMo[2018]について、#35〜#36ではself-attentionについて取り扱ってきました。

XLNet②(事前学習におけるAutoRegressiveとPermutation)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #10 - lib-arts’s diary

ALBERT③(The Elements of ALBERT)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #23 - lib-arts’s diary

#37以降ではDecomposable Attentionを確認するにあたって"

A Decomposable Attention Model for Natural Language Inference"について取り扱います。

[1606.01933] A Decomposable Attention Model for Natural Language Inference

#37ではAbstractとIntroductionの確認を行います。

以下目次になります。

1. Abstract

2. Introduction(Section1)

3. まとめ

1. Abstract

1節ではAbstractの内容を確認しながら概要について把握します。以下各文の和訳などを通して簡単に内容を確認します。

We propose a simple neural architecture for natural language inference. Our approach uses attention to decompose the problem into subproblems that can be solved separately, thus making it trivially parallelizable.

和訳:『(この論文では)自然言語の推論のためのシンプルなニューラルネットワークのarchitectureを提案する。我々の手法は問題を分離して解くことのできてささやかながら並列処理ができるサブ問題に分解するattentionを用いている。』

Decomposable Attention Modelが論文のテーマですが、こちらについて言及がされています。詳細についてはSection3などで言及があるようなので、そちらとともに確認するのが良さそうです。

On the Stanford Natural Language Inference (SNLI) dataset, we obtain state-of-the-art results with almost an order of magnitude fewer parameters than previous work and without relying on any word-order information.

和訳:『Stanford Natural Language Inference(SNLI)データセットにおいて、我々の研究はSotAの結果を出したが、同時に従来研究よりも圧倒的に少ないパラメータ数でword-orderの情報に依存しなかった。』

精度面でのパフォーマンスとしてSotAを実現するのと同時に少ないパラメータで実現できたとあり、効率面で優れた手法であるというのがここでは述べられています。

Adding intra-sentence attention that takes a minimum amount of order into account yields further improvements.

和訳:『intra-sentence attentionを加えることでさらなる改善が得られた。』

intra-sentence attentionについても言及されており、こちらについても詳細の記述とともに確認するのが良さそうです。

2. Introduction(Section1)

2節ではSection1のIntroductionについて確認します。以下パラグラフ単位で確認していきます。

第一パラグラフでは、NLI(Natural Language Inference)タスクがdetermining entailment and contradictionを取り扱うとされており、タスクの詳細は第三パラグラフと第四パラグラフで具体例とともに紹介されています。また、このNLIタスクに対して新しいモデル(Decomposable Attention Model)を提案するとされています。

第二パラグラフでは、NLIタスクへのニューラルネットワークの導入について近年盛んであることについて言及し、研究トレンドの中心がCNNやLSTMを用いたものになっていることについて紹介されています。一方でCNNやLSTMを用いたアプローチは大きな成果をあげているものの、計算コストの面での課題が指摘されています。

第三パラグラフでは、計算コストの問題を解決するにあたって提案する新しい手法について示唆しつつ、NLIのタスクの例として具体的な文を用いて紹介しています。

第四パラグラフでは、第三パラグラフで具体的に例示された文の解説を行なっており、第一文の要約として第二文は正しいが、第三文は正しくないことについて言及されています。

第五パラグラフでは、この研究で導入する手法について言及されています。

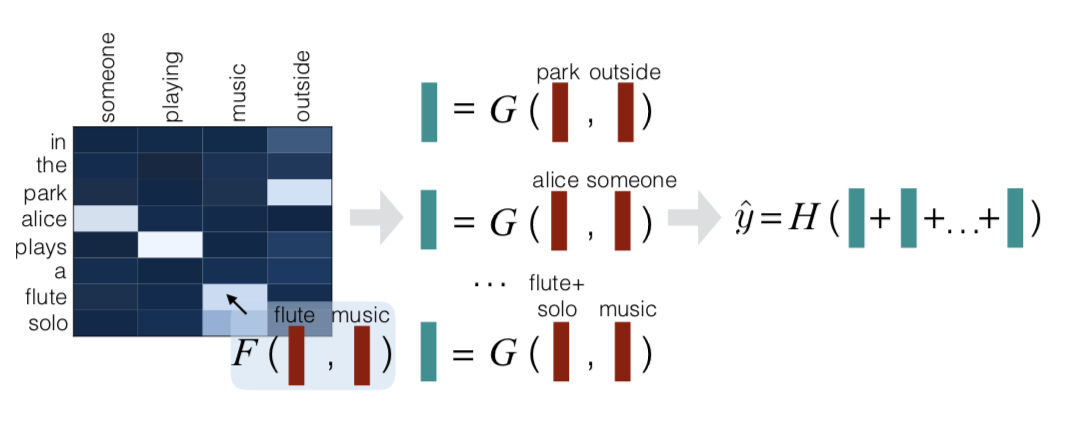

上記で表されるFigure1に処理の概要はまとめたとされており、Attend、Compare、Aggregateの三つのステップを用いてを計算するとされています。詳しくはSection3で取り扱われているので、#38の際に確認します。

第六パラグラフはここでは飛ばします。

3. まとめ

#37ではDecomposable Attention Modelについての論文である、"A Decomposable Attention Model for Natural Language Inference"のAbstractとIntroductionを確認し、論文の概要を掴みました。

#38ではRelated Work以下の重要なポイントについて取り扱っていきます。