CTRL: A Conditional Transformer Language Model for Controllable Generation①(Abstract & Introduction)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #42

言語処理へのDeepLearningの導入をご紹介するにあたって、#3〜#8においては、Transformer[2017]やBERT[2018]について、#9~#10ではXLNet[2019]について、#11~#12ではTransformer-XL[2019]について、#13~#17ではRoBERTa[2019]について、#18~#20ではWord2Vec[2013]について、#21~#24ではALBERT[2019]について、#26〜#30ではT5[2019]について、#31〜#32ではERNIEについて、#33〜#34ではELMo[2018]について、#35〜#36ではself-attention、#37〜#38ではDecomposable Attentionについて、#39〜#41ではReformer[2020]について取り扱ってきました。

#42以降では条件付きのTransformerを用いることで、生成の制御を行うCTRL(Conditional TRansformer Language Model)に関する下記の論文を取り扱っていきます。

[1909.05858] CTRL: A Conditional Transformer Language Model for Controllable Generation

#42ではAbstractとIntroductionを確認し、論文の概要を把握します。

以下目次になります。

1. Abstract

2. Introduction(Section1)

3. まとめ

1. Abstract

1節ではAbstractの内容を確認しながら概要について把握します。以下各文の和訳などを通して簡単に内容を確認します。

Large-scale language models show promising text generation capabilities, but users cannot easily control particular aspects of the generated text.

和訳:『大規模な言語モデルは期待できるほどのテキスト生成のキャパシティを示しているが、ユーザーは生成するテキストを容易に制御することはできないようになっている。』

BERTに代表されるTransformerをベースにした事前学習モデルの成功により、言語の汎用的な表現の取得ができるようになってきたことについて上記では言及しています。とはいえ、BERTなどはオーソドックスに様々なタスクに適用できるように構成されているので、そのまま用いるだけでは生成モデルの制御にあたっては不十分です。

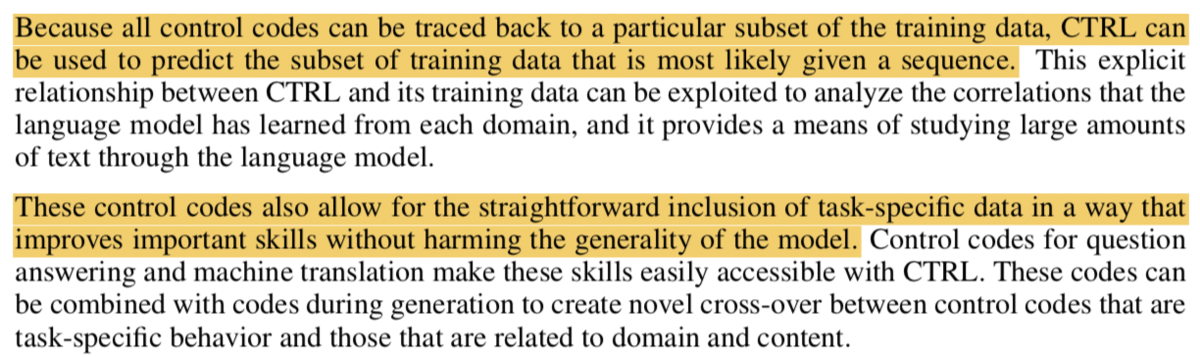

We release CTRL, a 1.63 billion-parameter conditional transformer language model, trained to condition on control codes that govern style, content, and task-specific behavior. Control codes were derived from structure that naturally co-occurs with raw text, preserving the advantages of unsupervised learning while providing more explicit control over text generation.

和訳:『我々は文体や内容、タスク特化型の振るまいのコントロールができるように学習させた、16.3億のパラメータの条件付きTransformer言語モデルのCTRLをリリースする。制御を行うコードは入力のテキスト(raw text)の共起に本質的に基づく構造に派生し、制御コードは同時にテキスト生成における明示的な制御を与える際において教師なし学習の利点を保持している。』

そこでこのCTRLの研究では、文体や内容やタスクに特化した振る舞いを制御できるようにモデルを構築しているとされています。

These codes also allow CTRL to predict which parts of the training data are most likely given a sequence. This provides a potential method for analyzing large amounts of data via model-based source attribution. We have released multiple full-sized, pretrained versions of CTRL at https://github.com/salesforce/ctrl.

和訳:『これらの制御コードを用いることで、CTRLは学習データのどの部分が与えられた系列に尤もらしいかを予測することができる。このことにより、model-basedな属性を介して大規模なデータの分析が可能となっている。我々はCTRLのフルサイズの事前学習バージョンを"https://github.com/salesforce/ctrl"に公開した。』

学習済みモデルはGitHubに公開したとされています。

2. Introduction(Section1)

2節ではSection1のIntroductionについて確認します。以下パラグラフ単位で確認していきます。

第一パラグラフでは、サンプル生成を行うにあたっては十分なデータとモデルのキャパシティと計算能力が必要として上で、画像処理における敵対的生成ネットワーク(GAN; Generative Adversarial Networks)のような画像の生成やその後の研究として画像生成の制御を試みた研究について紹介しています。

第二パラグラフでは、言語の生成を行うにあたって条件付きの言語モデルを用いたアプローチについて言及し、使用されている例としてWord2vecなどが挙げられています。これらを受け、テキスト生成の明示的な制御を行うにはどうしたら良いかという問題提起がなされています。

第三〜五パラグラフでは、テキスト生成における制御について言及されているようです。文章だけではわかりにくいのと、詳細は後述されているのでここでは省略します。

第六パラグラフでは、将来研究などを容易にするために実装をGitHubに公開したことについて言及がされています。

3. まとめ

#42では条件付きのTransformerを用いることで、生成の制御を行うCTRL(Conditional TRansformer Language Model)の論文のAbstractとIntroductionを確認し、論文の概要を把握しました。

#43では引き続き、Section2のLanguage Modeling以降について確認していきます。

Survey論文の確認⑤(3D Point Cloud Segmentation)|3D Point CloudsとDeepLearning #5

点群(Point Clouds)の基本的な内容については以前の記事で取り扱いました。

点群に対しても近年DeepLearningの導入が検討されており概要を掴むにあたって、下記のSurvey論文を元に読み進めています。

[1912.12033] Deep Learning for 3D Point Clouds: A Survey

#1ではAbstractについて、#2ではIntroduction(Section1)について、#3では3D Shape Classification(Section2)について、#4では3D Object Detection and Tracking(Section3)について取り扱いました。

Survey論文の確認①(Abstractと概要)|3D Point CloudsとDeepLearning #1 - Liberal Art’s diary

https://lib-arts.hatenablog.com/entry/point_clouds_dl2

https://lib-arts.hatenablog.com/entry/point_clouds_dl3

https://lib-arts.hatenablog.com/entry/point_clouds_dl4

#5ではSection4の3D Point Cloud Segmentationについて取り扱っていきます。

以下目次になります。

1. 3D Point Cloud Segmentation(Section4)

2. 3D Semantic Segmentation(Section4-1)

2-1. Projection-based Networks(Section4-1-1)

2-2. Point-based Networks(Section4-1-2)

3. Instance Segmentation(Section4-2)

3-1. Proposal-based Methods(Section4-2-1)

3-2. Proposal-free Methods(Section4-2-2)

4. Part Segmentation(Section4-3)

5. まとめ

1. 3D Point Cloud Segmentation(Section4)

1節ではSection4の冒頭部について確認します。

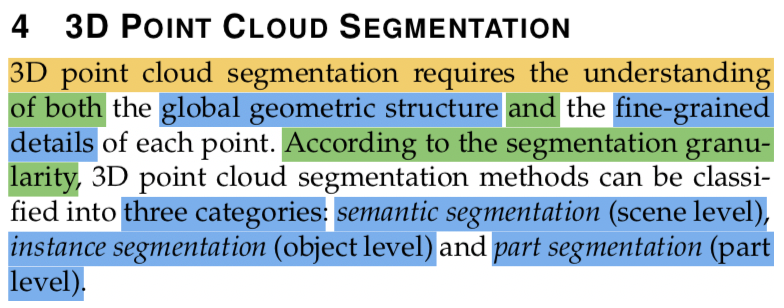

3D Point Cloud Segmentationを行うにあたっては、大域的な位置的な構造と各点の詳細な情報が必要になるとされています。また、3D Point Cloud Segmentationは三つのカテゴリに分類できるとしており、semantic segmentation(scene level)、instance segmentation(object level)、part segmentation(part level)、の三つだとされています。これらはそれぞれSection4-1〜Section4-3で取り扱われているので、以下それに合わせて2節〜4節で確認していきます。

2. 3D Semantic Segmentation(Section4-1)

2節ではSection4-1の3D Semantic Segmentationについて取り扱います。

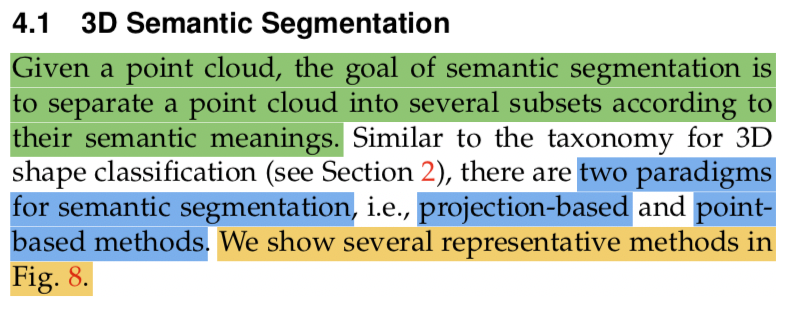

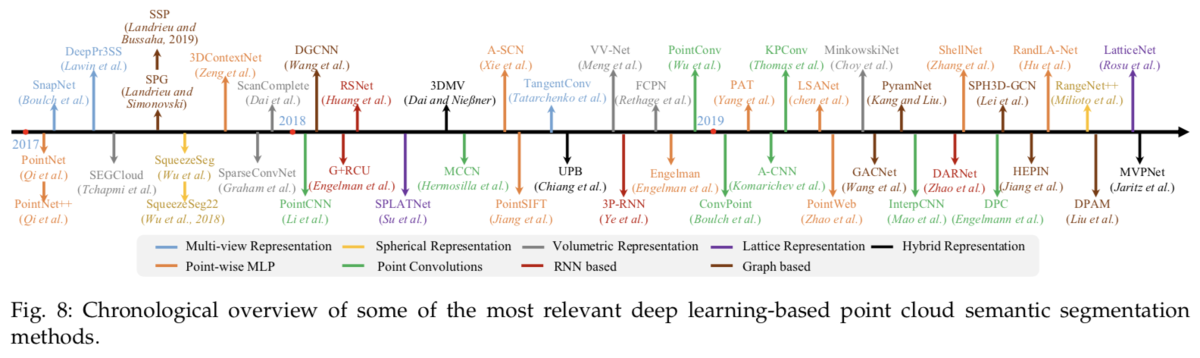

冒頭部の記載としては、Semantic Segmentationのタスク概要として点群が入力として与えられた際に、それぞれの点の意味に合わせていくつかの点の集合に分けることについて言及されています。手法としては、Section2の3D shape classificationで取り扱ったものと同様に、projection-based methodsとpoint-based methodsの二つに分けることができるとされています。

また、上記のようにFig.8に手法のまとめがあるとされています。2017年〜2019年にかけて列挙されています。

2-1. Projection-based Networks(Section4-1-1)

2-1節ではSection4-1-1のProjection-based Networksについて確認します。

Projection-based Networksの分類として、multi-view representation、spherical representation、volumetric representation、permutohedral lattice representation、hybrid representationが紹介されています。分類はSection2に似たようなものになっています。

それぞれの概要については上記のFig.9に図示されています。

2-2. Point-based Networks(Section4-1-2)

2-2節ではSection4-1-2のPoint-based Networksについて確認します。

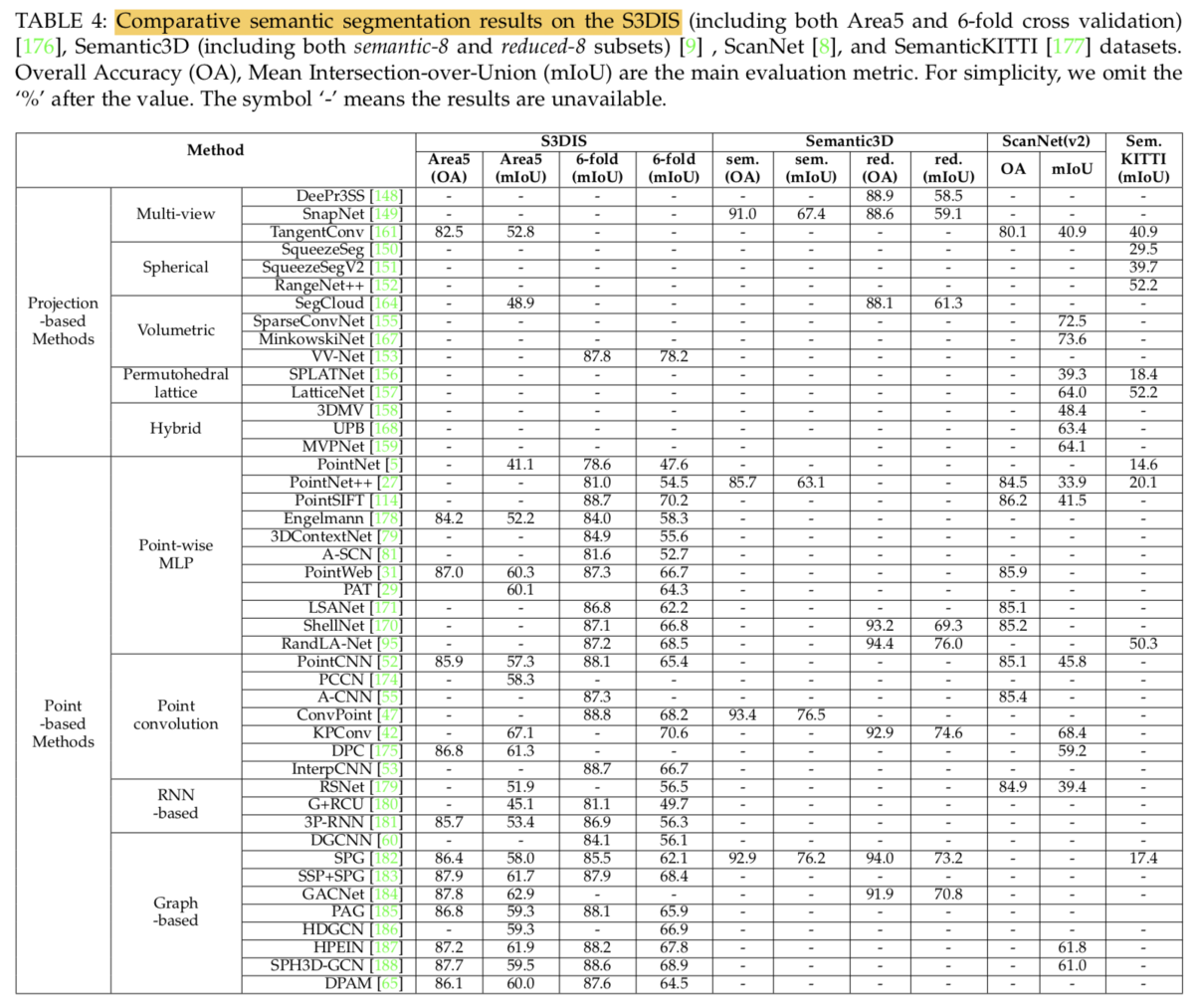

Point-based Networksは不規則性を持つ点群をそのまま取り扱うとされています。また、初期の研究であるPointNetの構造に基づいて様々な研究が行われているとなっています。手法を分類すると、pointwise MLP methods、point convolution methods、RNN-based methods、graph-based methods、になるとされています。

また、Section4-1で取り扱った研究について、上記のTable4で取りまとめられています。

3. Instance Segmentation(Section4-2)

3節ではSection4-2のInstance Segmentationについて取り扱います。

冒頭部の記載としては、Instance SegmentationのタスクがSemantic Segmentationのタスクに比べてチャレンジングであることについて言及した上で、点のより正確な見分けが必要になるとされています。また、既存手法は大まかにproposal-based methodsとproposal-free methodsの二つに分けられるとされています。

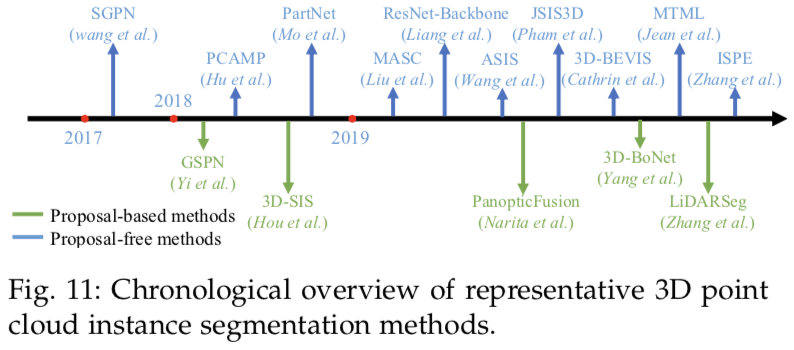

また、上記のFig.11に2017〜1019年の研究が列挙されています。

3-1. Proposal-based Methods(Section4-2-1)

3-2. Proposal-free Methods(Section4-2-2)

こちらについては今回は省略します。

4. Part Segmentation(Section4-3)

今回は省略します。

5. まとめ

#5ではSection4の3D Point Cloud Segmentationについて取り扱いました。

Surveyについては一通り確認できたので、#6以降は今回のSurvey全体を通してよく出てきた研究であるPointNetについて読み進めていければと思います。

因果の概要を把握する|因果推論入門 #1

時折因果推論について目にするので、入門にあたって簡単にまとめておければということで新シリーズとして「因果推論の入門」について取り扱っていきます。

#1では入門にあたって、大枠の把握について行えればと思います。

以下、目次になります。

1. 相関関係と因果関係

2. 因果推論とは

3. まとめ

1. 相関関係と因果関係

1節では相関関係と因果関係について見ていきます。簡単に言葉で表すと相関は二つの変数に関連性があること、因果は相関関係がある上でどちらかがどちらかの原因になっていることがそれぞれ大まかに違います。以下Wikipediaの記述について確認していきます。

上記がWikipediaの冒頭の記述ですが、因果関係は相関関係の特殊なケースと考えておくと良さそうです。

上記でも同様に記述されており、「相関は因果を含意しない」や「相関関係は因果関係の単なる必要条件の1つ」と記述されています。

相関と因果は相関の方が広い概念で、上記ではAとBに相関がある場合、様々な可能性があるとされています。

誤謬の例としては上記などが挙げられています。

因果推論の判定としてデイヴィッド・ヒュームは「因果関係は具体的推論に基づかない」と結論づけており、観測できるのは相関関係だけであるとここでは記述されています。

また、科学的なアプローチとして、化学的実験と統計的手法が紹介されています。個人の等価性や集団の等価性をもってA/Bテストのような検証を行うことで判断を行うことについてここでは記載されています。

2. 因果推論とは

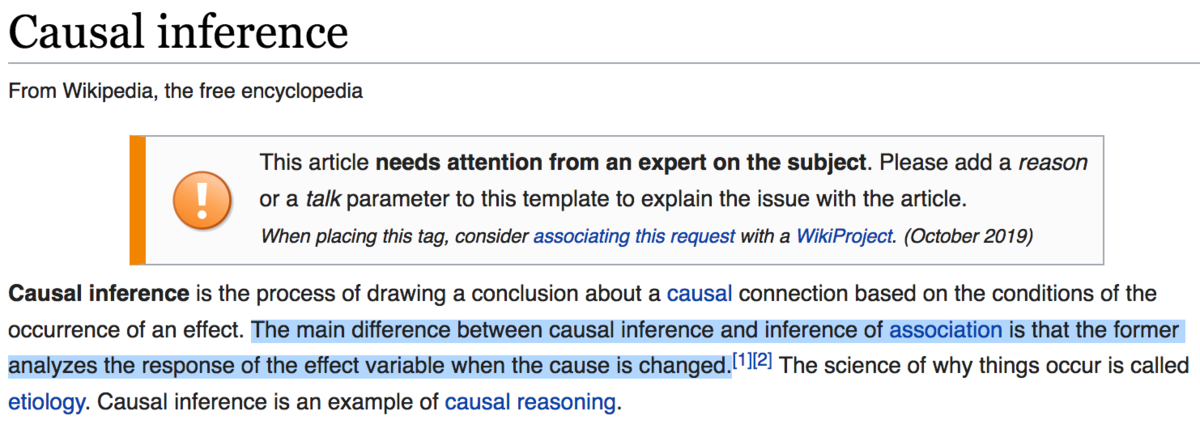

2節では英語版のWikipediaから"Causal inference"の項目を確認します。

まず概要としては、1節と同様な内容について記述されています。因果推論がcausal inference、相関分析がinference of associationで記載されていることは抑えておくと良いと思います。

"Computer Science"における記述があったのでこちらについて見ていきます。ここでXとYは2つの時間に独立な変数(time-independent variables)とされています。X->YやY->Xの構造があれば因果関係だと言えるのですが、主要なアプローチとして、Algorithmic information theory modelsとnoise modelsの二つが紹介されています。

3. まとめ

大体の大枠の言葉の整理はできたので#1はここまでとします。

#2ではなんらかのまとめの資料を読み進められればと思います。

DeepLearning 関連論文の読み方手引き(上巻)|電子テキスト紹介 #4

当ブログの内容を元に電子テキストやその印刷版を、技術書典やnoteやboothなどのプラットフォームで販売を行なっているのですが、あまり内容について紹介してこなかったのでちょっとした宣伝も兼ねてご紹介していくシリーズです。

#1では「高校数学の演習から理解する、機械学習アルゴリズム」について、#2では「Python実装を通して学ぶ、統計モデリング入門」について、#3では「Deep Q-Network を通して学ぶ、強化学習超入門」についてご紹介しました。

高校数学の演習から理解する、機械学習アルゴリズム|電子テキスト紹介 #1 - Liberal Art’s diary

https://lib-arts.hatenablog.com/entry/e-book2

https://lib-arts.hatenablog.com/entry/e-book3

#4では、DeepLearning関連の論文を原文で読む際に参考になるように手引きとしてまとめた、「DeepLearning 関連論文の読み方手引き」の上巻についてご紹介します。

以下目次になります。

1. 作成にあたってのコンセプト

2. 簡単な内容の紹介

3. 今後のアップデート予定について

4. まとめ

1. 作成にあたってのコンセプト

こちらのテキストを作成するに至った背景やテキストのコンセプトですが、「論文を読む」って難しいと思われがちな一方で、DeepLearning関連の論文については非常に読みやすいものが多いため、そういった誤解をなくせればというのがあります。「最先端の論文を読む」っていうと凄く難しそうに聞こえますが、基礎知識+ちょっとした訓練で簡単に読めるようになります。

とはいえある程度、基本的な知識のベースはいるので、本テキストでは下記を対象読者と設定することで、事前知識を想定しています。

・SVOC、関係代名詞、that節など、英語の基本構文は問題ない方(時間をかけても良いので1文ずつ文の構成は掴める状態を前提とします。自信のない方は高校レベルの英文法を先に一度抑えた上で読んでいただく方が良いと思います)

・CNN、RNN、AlexNet、VGGNet、ResNetなどの基本的なDeepLearningの理解がある方(入門書を2〜3冊程度読んでいる前提です)

・モデル、学習、推論など基本的な機械学習についての理解がある方

・微積分(特に微分)と線形代数の簡単な知識(行列の積と逆行列、固有値までの簡単な理解)がある方(基本的な内容がある程度わかっているレベルで大丈夫です)

上記は英語検定準2級〜2級、数学検定準2級〜2級くらいのレベル感で、高校卒業レベル+αくらいを想定しています。大学1〜2年であれば少しだけ並行で調べながら読む、3〜4年であればそのまま読むような内容になっているのではないかと思います。

「機械学習関連の論文を読むのはそれほど難しいことではない」というのを、テキストを読み進めるのを通してご理解いただけたら良いなと考え作成しました。

2. 簡単な内容の紹介

2節では簡単に内容についてご紹介します。

まず第1章では序論(Introduction)として、「論文を読めるようになるにあたっての戦略」についてまとめています。「構成を知る」ということと、「読み方」、「最初に何から読むべきか」などについてまとめています。大概の論文は同じ構成で記述されているため、ある程度パターンをつかむことでスムーズに読み進めることができるようになります。

第2章以降では実際に論文を読むにあたってのケーススタディとして、いくつか論文を紹介し、読み進めています。第2章ではDeepLearningが流行するようになったきっかけとして、画像分類(Image Classification)の研究について紹介しています。非常に有名な研究として、AlexNet[2012]、VGGNet[2014]、ResNet[2015]などを紹介しています。

第3章ではImage Segmentation(画像の意味分割)について取り扱っています。有名どころの研究としてFCN[2014]、U-Net[2015]について紹介したのちに、発展項目としてInstance Segmentationタスクについて取り扱った、Mask RCNN[2017]についてご紹介しています。

第4章では生成モデル(Generative Model)について取り扱っています。生成モデルにDeepLearningを導入したベースの研究としてGenerative Adversarial Networks[2014]についてご紹介したのちに、安定化を試みた手法であるDCGAN[2015]や、応用トピックとして画像変換への適用を試みた、Pix2Pix[2016]、CycleGAN[2017]、StarGAN[2017]についてもご紹介しています。

3. 今後のアップデート予定について

上巻のアップデートよりも下巻の執筆を優先しようと考えています。

1-4節で上記のように記したのですが、第5章で物体検出(Object Detection)、6章で言語処理(Natural Language Processing)、7章で強化学習(Reinforcement Learning)、8章でその他について取り扱う予定です。

4. まとめ

#4では、DeepLearning関連の論文を原文で読むにあたっての手引きとしてまとめた、「DeepLearning 関連論文の読み方手引き」の上巻についてご紹介しました。

#5では実務で用いやすい言語処理ということで、「簡易Pythonコードで学ぶ、実践的自然言語処理入門」をご紹介できればと思います。

Survey論文の確認④(3D Object Detection and Tracking)|3D Point CloudsとDeepLearning #4

点群(Point Clouds)の基本的な内容については以前の記事で取り扱いました。

点群に対しても近年DeepLearningの導入が検討されており概要を掴むにあたって、下記のSurvey論文を元に読み進めています。

[1912.12033] Deep Learning for 3D Point Clouds: A Survey

#1ではAbstractについて、#2ではIntroduction(Section1)について、#3では3D Shape Classification(Section2)について取り扱いました。

https://lib-arts.hatenablog.com/entry/point_clouds_dl1

https://lib-arts.hatenablog.com/entry/point_clouds_dl2

https://lib-arts.hatenablog.com/entry/point_clouds_dl3

#4ではSection3の3D Object Detection and Trackingについて取り扱っていきます。

以下目次になります。

1. 3D Object Detection(Section3-1)

1-1. Region Proposal-based Methods(Section3-1-1)

1-2. Single Shot Methods(Section3-1-2)

2. 3D Object Tracking(Section3-2)

3. 3D Scene Flow Estimation(Section3-3)

4. まとめ

1. 3D Object Detection(Section3-1)

1節ではSection3-1の3D Object Detectionについて確認します。

まずはSection3全体の冒頭部も含めて冒頭部を確認します。まずSectionの冒頭部としては、Section3全体として3D object detection(Section3-1)、3D object tracking(Section3-2)、3D scene flow estimation(Section3-3)を取り扱うとしています。それぞれ1〜3節で取り扱っていきます。また、Section3-1の冒頭部の記載としては、3D object detectionを二つのカテゴリに分けておりそれぞれ、(1)region proposal-based methods(Section3-1-1)、(2)single shot methods(Section3-1-2)であるとしています。これらは通常のObject Detectionにおいて、(1)がFast RCNNやFaster RCNN、(2)がSSDやM2Detに対応すると考えておくと良さそうです。また、Fig.6に研究におけるいくつかのマイルストーンとなった研究を紹介しているとしています。

1-1. Region Proposal-based Methods(Section3-1-1)

1-1節ではSection3-1-1のegion Proposal-based Methodsについて確認します。

まず上記では、Region Proposal-based Methodsを三つのカテゴリに分けており、multi-view-based、segmentation-based、frustum-based methodsの三つを挙げています。

それぞれの手法の概要は上記のFig.7に図示されています。(a)がmulti-view based methodsでいくつかのViewを元に畳み込みを行い、そこからRoI(Region of Interest)を抽出する手法になっています。研究例としてはMV3Dが挙げられています。(b)がsegmentation-based methodsで、まずsemantic segmentationを行うことで背景を分離し、計算量を減らすとされています。研究例としてはPointRCNNが挙げられています。(c)がfrustum-based methodsで、2Dの画像の情報を3Dの点群に組み合わせることでRoIの抽出を行なっているとされています。研究例としてはFrustum PointNets(F-PointNets)が挙げられています。

1-2. Single Shot Methods(Section3-1-2)

1-2節ではSection3-1-2のingle Shot Methodsについて確認します。

冒頭部の記載では、Single Shot MethodsではRoIを計算せずに直接クラスの確率や3Dのobjectのbounding boxesを回帰するとしています。このことにより、結果として高速な処理が可能になるため、リアルタイムでの応用に適しているとされています。また、このSingle Shot Methodsは2つのカテゴリに分けることができそれぞれ、(1)BEV-based methods、(2)point-based methods、の二つが挙げられています。ここでBEVはBird's Eye Viewの略で鳥瞰図を意味しています。

上記のTable2で3D Object Detectionのそれぞれの手法と、ベンチマークのスコアがまとめられています。上記で頭を整理しつつ、詳細が気になれば都度調べていくというのが良さそうです。

2. 3D Object Tracking(Section3-2)

2節ではSection3-2の3D Object Trackingについて取り扱います。

冒頭部の記述では、3D Object Trackingのタスク概要として「初期フレームにおけるobjectの位置が与えられた際に、それに続くフレームにおけるそのobjectを推定する」ということや、3D Object Trackingに対する期待として「2Dの際にネックとなっている、objectの重なりやスケール変化の問題などの欠点を克服することが望まれる」ということが記述されています。

詳細については簡単な説明のみであったため、ここでは省略します。

3. 3D Scene Flow Estimation(Section3-3)

3節ではSection3-3の3D Scene Flow Estimationについて取り扱います。

冒頭の記載としては、3D Scene Flow Estimationの概要について2Dの画像処理におけるoptical flowの推定の類似として説明を行なっています。点群の系列(sequence of point clouds)から、3D scene flowやspatial-temporary informationなどの有用な情報を学習することをいくつかの手法が試み始めていることについて記載されています。また、具体的な研究例として、FlowNet3DやHPLFlowNetなどが紹介されています。

4. まとめ

#4ではSection3の3D Object Detection and Trackingについて確認しました。

#5では引き続きSection4の3D Point Cloud Segmentationについて取り扱っていきます。

「詭弁」と「論理学」②|ロジカルシンキングを学ぶ #2

連載の経緯は#1に記しました。

https://lib-arts.hatenablog.com/entry/logical-thinking1

演繹的な論理学から入ると導入としては抽象的で難しいものになりそうなため、#1では「詭弁」と「論理学」ということで、ロジカルシンキングがうまくいっていない例を見つつ、それを論理学的に整理を行いました。

Wikipediaに「詭弁」の例として29例が挙げられていましたが、#1では9例しか確認できなかったため、#2では12例、#3では8例を見た上で、#3で論理学的にそれぞれを整理し、回避するにはどうしたら良いかについても議論ができればと思います。

以下目次になります。

1. 「詭弁」の具体例②

2. 論理学に基づいた「詭弁」の整理②

3. まとめ

1. 「詭弁」の具体例②

1節では#1に引き続き、「詭弁」の具体例についてご紹介していきます。Wikipediaには29の具体例が挙げられているので、今回は10番目〜21番目の12例について取り扱います。

10例目としては、誤った二分法(false dilemma)が紹介されています。XはYとZの二つのどちらかであるという前提が正しくないのにも関わらずそれを仮定し、二つのうちの一つを否定することでもう一つを主張しようという論法です。営業や交渉のテクニックなどでこの辺はよく用いられている印象で、二択もしくは幾つかの選択肢を提示することで、逆にそれ以外の選択肢に関する思考を行わないように誘導するような論理構成になっています。

11例目としては、隙間の神(God of the gaps)が紹介されています。#1で9例目として取り扱った未知論証の一つとして神の存在を持ち出して説得を行なっています。

12例目としては、論点のすりかえ(Ignoratio elenchi)が紹介されています。政治家の答弁などでよく見られる論法です。違う話題を提示することで元々の論点と違う議論にしようとします。日常でも時折見られるこの論点のすりかえですが、対処法としては、「簡潔にお話ください」や「一言で言うと何ですか」などで判別することができます。論点のすりかえは、情報量で聞き手の思考を混乱させる論法のため、「一言でまとめる」ことができません。こうなってくると大体のケースで論理破綻が生じます。

13例目としては、ストローマン(Straw man)が紹介されています。相手の主張を極論化し、元々の主張に含まれていない事柄を加えることで論点のすりかえを行う論法です。こちらについても非常によく目にする論法です。

14例目としては、対人論証(ad hominem abusive)が紹介されています。発言者の主張ではなく発言者自身に対して個人攻撃を行うことで反論を行う論法です。発言者の主張の論理的な正否と無関係な主張のため、論理的に正しい反論ではないです。マスコミやSNSなどのメディアでよく用いられている論法である印象です。これも論点のすりかえとされています。

15例目としては、連座の誤謬(guilt by association)が紹介されています。こちらは対人論証の一種とされています。

16例目としては、状況対人論証(circumstantial ad hominem)が紹介されています。こちらについても対人論証の一つとされています。

17例目としては、自然主義の誤謬(Naturalistic fallacy)が紹介されています。「である」と言う観察事実から「べきである」と言う指針を引き出す論法であり、「である」から「べきである」を引き出すことはできないという主張をヒュームの法則と呼んでいるそうです。

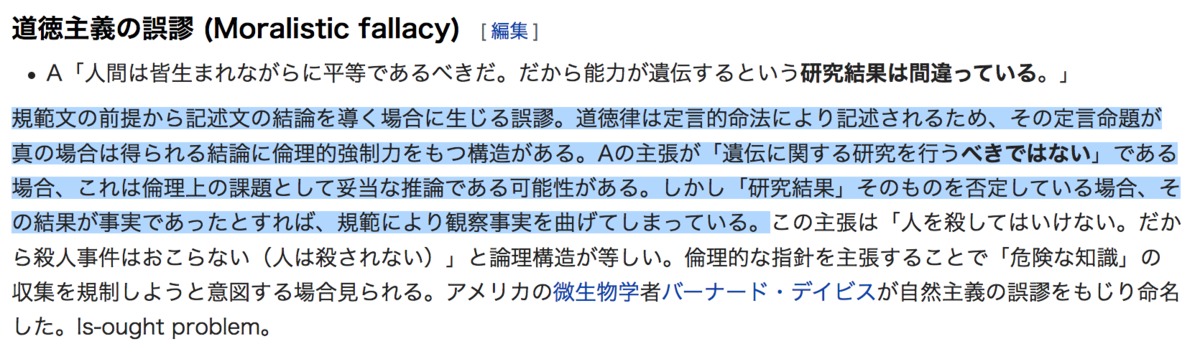

18例目としては、道徳主義の誤謬(Moralistic fallacy)が紹介されています。道徳や規範を持って事実の結果を否定するという論法になっています。日本人がよく使いがちな論法で、戦時中の軍部内や現代の政治のシーンなどでもよく用いられている印象です。17例目とは反対に「べきである」から「である」を導き出そうとしています。

19例目としては、同情論証(ad misericordiam)が紹介されています。マスメディアがよく用いている論法で、個別ケースへの同情を持って論点をすりかえようとする論法になっています。

20例目としては、伝統に訴える論証(Appeal to tradition)が紹介されています。こちらもよく使われる論法で、前提の状況が異なる際などは注意が必要です。

21例目としては、新しさに訴える論証(Appeal to novelty)が紹介されています。こちらもよく使われる印象で、「最新の」をキャッチコピーに無駄なものを買わせようとするケースなどはどの業界でも多いのではと思います。

2. 論理学に基づいた「詭弁」の整理②

今回は「論点のすりかえ」関連の論法が多い内容となっていました。下記に今回取り扱った例の分類について簡単にまとめておきます。

・命題(仮定と結論)についての論理や集合論

-> 前回に引き続き、10例目と11例目は集合論などで整理しておくと良いと思います。・論点のすりかえ

-> 12例目として出てきた「論点のすりかえ」は様々な状況で用いられています。12〜16、19〜21は論点のすりかえと考えて良いと思います。また、14〜16の対人論証はよく見かける論法のため、注意が必要であると思います。・「である」と「べきである」

-> 17と18は対になっており、自然を観測した結果の「である」と道徳や倫理としての「べきである」というものを、それぞれをもう片方の根拠として用いています。この辺の論理展開についてはかなり慎重な取り扱いが必要であると考えるべきであると思います。

今回取り扱った例は「論点のすりかえ」が非常に多くなっていました。例としても多いですが、あらゆるシーンで「論点のすりかえ」は起こりやすいので、非常に注意が必要です。

3. まとめ

#2では#1に引き続き、「詭弁」の具体例を12例確認しました。

#3では引き続き、8例を見た上で論理学的にそれぞれを整理し、29例を総括して回避するにはどうしたら良いかについて考察できればと思います。

Survey論文の確認③(3D Shape Classification)|3D Point CloudsとDeepLearning #3

点群(Point Clouds)の基本的な内容については以前の記事で取り扱いました。

点群に対しても近年DeepLearningの導入が検討されており概要を掴むにあたって、下記のSurvey論文を元に読み進めています。

[1912.12033] Deep Learning for 3D Point Clouds: A Survey

#1ではAbstractについて、#2ではIntroduction(Section1)について取り扱いました。

https://lib-arts.hatenablog.com/entry/point_clouds_dl1

https://lib-arts.hatenablog.com/entry/point_clouds_dl2

#3ではSection2の3D Shape Classificationについて取り扱っていきます。

以下目次になります。

1. 冒頭部(3D Shape Classification_Section2)

2. Projection-based Networks(Section2-1)

2-1. Multi-view representation(Section2-1-1)

2-2. Volumetric representation(Section2-1-2)

3. Point-based Networks(Section2-2)

3-1. Pointwise MLP Networks(Section2-2-1)

3-2. Convolution-based Networks(Section2-2-2)

3-3. Graph-based Networks(Section2-2-3)

3-4. Data Indexing-based Networks(Section2-2-4)

3-5. Other Networks(Section2-2-5)

4. まとめ

1. 冒頭部(3D Shape Classification_Section2)

1節ではSection2の冒頭部について確認します。

第一パラグラフでは、3D Shape Classificationの概要として、「全ての点のembeddingを学習した上で、全体の点群から全体のshape embeddingを抽出し、分類(classification)を行う」と紹介しています。実際に計算を進めていくにあたって3D Shape Classificationの手法はprojection-based networksとpoint-based networksの二つあるとされており、それぞれSection2-1とSection2-2で取り扱われてます。また、研究のmilestoneについてFig.2で取り扱っているとしています。

Fig.2では研究の時系列に沿っての外観(Chronological overview)がまとめられています。

第二パラグラフでは、projection-based methodsとpoint-based methodsの二つについてそれぞれ簡単に説明しています。projection-basedの手法では構造化されていない(unstructured)点群を中間正則表現(intermediate regular representation)に変換(project)し、shape classificationにあたっての2Dや3Dの畳み込みに影響を及ぼすとされています。対比的に、point-basedの手法では、点群(point clouds)のdataをそのまま用いて計算するとされています。また、このサーベイではどちらの手法も取り扱うものの、主にpoint-basedのネットワークについて取り扱うとされています。

2. Projection-based Networks(Section2-1)

2節ではSection2-1のProjection-based Networksについて取り扱います。

冒頭部の記載では、3D point cloudsのデータ形式を変換するにあたっての表現として、multi-viewとvolumetric representationについて言及しています。それぞれSection2-1-1とSection2-1-2節で取り扱っているので、それぞれ以下で確認していきます。

2-1. Multi-view representation(Section2-1-1)

2-1節ではSection2-1-1のMulti-view representationについて確認します。

Multi-view representationでは、3Dの物体を複数の視点に投影し視点毎の特徴量(view-wise features)を抽出し、物体認識に用いるとされています。先駆的な研究としてMVCNNやその改善の研究であるMHBNなどが研究例としては紹介されています。

2-2. Volumetric representation(Section2-1-2)

2-2節ではSection2-1-2のVolumetric representationについて確認します。

(中略)

Volumetric representationでは立体のグリッドであるvoxel(pixelの3D版)における二次元の変数による確率分布によって3Dの形状を表現するとされています。研究例として、VoxNetなどが挙げられていますが、このアプローチは解像度(resolution)を上げるとその3乗に比例して計算量が大きくなるとされています。これを解消するにあたって、octreeのような階層型のコンパクトなグラフ構造が考案されたとしており、OctNetなどがその例として挙げられています。

3. Point-based Networks(Section2-2)

3節ではSection2-2のPoint-based Networksについて取り扱います。

冒頭部では、point-basedな手法の大別として、pointwise MLP(Section2-2-1)、convolution-based(Section2-2-2)、graph-based(Section2-2-3)、data indexing-based networks(Section2-2-4)、other typical network(Section2-2-5)が挙げられています。以下それぞれについて確認していきます。

3-1. Pointwise MLP Networks(Section2-2-1)

3-1節ではSection2-2-1のPointwise MLP Networksについて確認します。

第一パラグラフでは、Fig.3を元に計算の全体像について説明しています。

Fig.3では、PointNetのネットワーク構造を元にPointwise MLP Networksの処理の概要について説明しています。nは入力する点の数、Mはそれぞれの点の特徴量の次元であるとされています。

以降ではPointNetやPointNet++などを紹介しながら詳細について説明されています。

また、上記に記載があるように、多くの後発の研究はPointNetをベースに開発されているとなっています。

3-2. Convolution-based Networks(Section2-2-2)

3-2節ではSection2-2-2のConvolution-based Networksについて確認します。

基本的な処理の概要については上記のFig.4に記載されています。Fig.4の(a)のように点の近さを考え、その点に近い点の情報を元に畳み込みを行うとされています。畳み込みにあたっては(b)のように連続的な(continuous)畳み込み処理を行う手法と、(c)のように離散的な(discrete)畳み込み処理を行う手法について紹介されています。

3-3. Graph-based Networks(Section2-2-3)

3-3節ではSection2-2-3のGraph-based Networksについて確認します。

Graph-basedな手法では、以前の記事で取り扱ったConvGNNsと同様の処理を行なっているようです。

spatialなアプローチとspectralなアプローチについてそれぞれ説明されています。

3-4. Data Indexing-based Networks(Section2-2-4)

3-5. Other Networks(Section2-2-5)

今回は省略しますが、全体の手法の整理がTable1にまとまっているので、こちらだけご紹介します。

4. まとめ

#3ではSection2の3D Shape Classificationについて取り扱いました。

#4では引き続き、Section3の3D Object Detection and Trackingについて取り扱っていきます。