論文で理解するR2D2の概要|論文で理解する深層強化学習の研究トレンド #2

上記シリーズでRainbowを取り扱ったのですが、実装ベースというよりは論文ベースでも研究トレンドを把握しておきたいということで新シリーズとして『論文で理解する深層強化学習の研究トレンド』として始めていきたいと思います。

#1ではRainbowの後の2018年にDeepMindが発表した"Ape-X(DISTRIBUTED PRIORITIZED EXPERIENCE REPLAY)"についてご紹介しました。

論文で理解するApe-Xの概要|論文で理解する深層強化学習の研究トレンド #1 - lib-arts’s diary

#2ではApe-Xの後の2019年にDeepMindが発表した"R2D2(RECURRENT EXPERIENCE REPLAY IN DISTRIBUTED REINFORCEMENT LEARNING)"についてご紹介していきます。

https://openreview.net/pdf?id=r1lyTjAqYX

以下、目次になります。

1. R2D2の概要(Abstract、Introductionの確認)

1-1 Abstractの確認

1-2 Introductionの確認

2. 論文の重要なポイントの抜粋

2-1 Background(Section2)

2-2 Training Recurrent RL Agents With Experience Replay(Section3)

2-3 Experimental Evaluation(Section4)

3. まとめ

1. R2D2の概要(Abstract、Introductionの確認)

1-1 Abstractの確認

1-1節ではAbstractの内容を確認しながら概要について把握します。以下一文ずつ和訳とともに解説を行います。

Building on the recent successes of distributed training of RL agents, in this paper we investigate the training of RNN-based RL agents from distributed prioritized experience replay.

和訳:『強化学習のエージェントにおける分散学習の近年の成功において、この論文では分散型の優先度付き経験再生からRNNベースの強化学習エージェントの学習に対し実験を行なっている。』

分散型の優先度付き経験再生(distributed prioritized experience replay)については#1でまとめたApe-Xに言及していると思われます。

We study the effects of parameter lag resulting in representational drift and recurrent state staleness and empirically derive an improved training strategy.

和訳:『我々はパラメータのラグによって引き起こされるrepresentational driftの効果とrecurrent state stalenessの研究と、学習戦略の改善を総括的に導き出している。』

ここでの論述に対し、後ろの方ではRNNを導入することに対する詳細の記述があります。

Using a single network architecture and fixed set of hyper-parameters, the resulting agent, Recurrent Replay Distributed DQN, quadruples the previous state of the art on Atari-57, and matches the state of the art on DMLab-30.

和訳:『単一のネットワーク構造と固定されたハイパーパラメータの集合を用いることで、Atari-57において従来のSotAの四倍となり、DMLab-30においてもSotAに迫る結果となった。結果としてエージェントは再帰的分散再生Deep Q-Networkとなっている。』

Recurrent Replay Distributed Deep Q-NetworkにおいてRが2つ、Dが2つとなっているためスターウォーズにちなんでR2D2とされているようです。

It is the first agent to exceed human-level performance in 52 of the 57 Atari games.

和訳:『R2D2はAtariのゲームので人間のパフォーマンスを上回るモデルとなった。』

AtariのゲームはOpenAI Gymで実装されるなど、以前より強化学習アルゴリズムのパフォーマンスを計測するベンチマークとして用いられてきましたが、R2D2でもそれにならいAtariのゲームでアルゴリズムの評価を行なっています。

1-2 Introductionの確認

1-2ではIntroductionの確認を行っていきます。

以下パラグラフ単位でリーディングしていきます。

第一パラグラフでは、近年のAtariらのゲームにおいて強化学習のアルゴリズムが良いパフォーマンスを実現しているのに対して、より記憶ベースの表現(memory-based representation)が必要になってきているとされています。表現の例としてはRNNs(Recurrent Neural Networks)などが挙げられており、一例としてLSTMの導入などについてなどが言及されています。

第二パラグラフでは、experience replayを用いてRNNsの学習の実験を行うとされています。それに際して三つの重要なContributionを実現したとされており、(1)パラメータラグにおける経験再生の効果を示したこと、(2)experience replayを用いたRNNの学習へのいくつかのアプローチの効果性に対する包括的な研究を示したこと、(3)Atari-57において著しい進歩を獲得する発見を統合するエージェントを紹介したこと、の三点が挙げられています。

ここまでのAbstractとIntroductionの内容で大体のイメージがついたので1節はここまでとします。

2. 論文の重要なポイントの抜粋

2節ではSection2以降の論文の重要なポイントを抜粋していきます。基本的に章立てにならいますが、細かい記述には立ち入らないで進めていきます。

2-1 Background(Section2)

Section2.1ではReinforcement Learningということで、強化学習の基本的な内容についてまとまっています。次のSection2.2ではDistributed Reinforcement Learningについてということで、Ape-Xなどを中心に紹介が行われています。

Section2.3はThe Recurrent Replay Distributed Deep Q-Network Agentということで、R2D2の論文のテーマである強化学習へのRNNの導入について言及されています。若干本題も入っているので、下記パラグラフ単位で確認していきます。

第一パラグラフでは、強化学習を考えるにあたっての新しいエージェントとしてR2D2を導入するとされています。R2D2は#1でまとめたApe-X[2018]ににていて、prioritized distributed replayやn-step double Q-learning、dueling netowork architectureなどを踏襲しているとされています。

第二パラグラフでは、通常のtransitionとして用いられるではなくて、固定長(

)の系列(sequence)のtransitionとして

をメモリに保持するとあります。隣の系列は40timeステップでそれぞれオーバーラップしており、エピソード境界を決して跨がないとされています。この表現になっている背景としては、逐次的意思決定問題(sequential decision making problem)にMDPの前提を置かないということを意味しています。

第三パラグラフ、第四パラグラフでは、強化学習の問題定義にあたって、AtariやDMLabの仕様や報酬の設定の仕方、Q-value関数の設定などについて記載されています。

第五パラグラフ以降は細かい話のようなので飛ばします。

2-2 Training Recurrent RL Agents With Experience Replay(Section3)

Section3のTraining Recurrent RL Agents With Experience Replayについて確認していきます。

まず、第一パラグラフでは、強化学習の文脈において良い結果を出すためには、そのステップにおける観測情報(current observation)を用いるに加えて状態と行動の系列情報(state-action trajectory)についての情報をエンコードする状態の表現(representation)を強化学習のエージェントが必要とするとされています。これを実現するにあたっての最も一般的な方法としてRNN(典型的にはLSTMが用いられる)を利用することによって実現するとされています。

RNNの学習にあたってはFigure1の(a)のような形式でを計算するとされています。Deep Q-Networkにおいてはtransitionの中からランダムに1ステップ選び出して学習していたのに対して、Figure1の(a)ではRNNを用いて

の計算を行なっていることに注意です。これにより、従来の多くの強化学習において問題設定における大きな前提とされてきたMDP(Markov Decision Process)をここでは前提としていないというのが非常に大きなポイントです。

この時の工夫としては、上記のようにStored stateとBurn-inが言及されています。

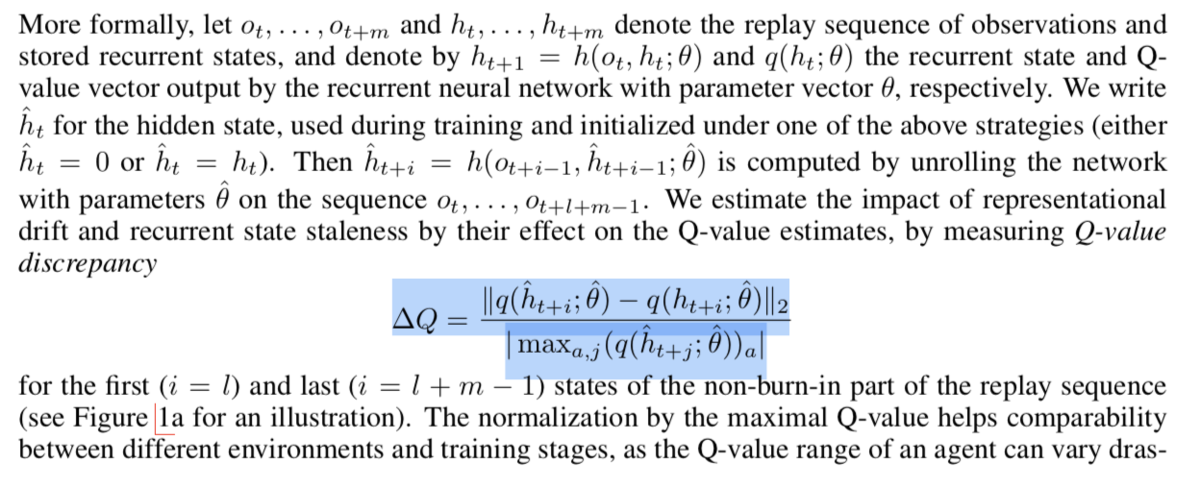

また、の計算式は上記のように定義されています。

2-3 Experimental Evaluation(Section4)

Section4.1ではAtariの結果についてまとめられています。

Figure2では、結果の比較についてまとめられています。R2D2は従来のモデルであるRainbowやApe-Xなどを大きく上回るパフォーマンスとなっていることが図で示されています。

3. まとめ

#2ではR2D2[2019]について取り扱いました。RNNを強化学習に導入することで、MDP(Markov Decision Process)という強化学習を考えるにあたって標準的に用いられていた前提を取り払ったというのが非常に面白い内容でした。

#3ではより報酬がなかなか得られないより難しいタスクに取り組んだ研究としてR2D3[2019]について取り扱います。