ScanNetの論文を把握する②(Previous Work以降) #2

3D再現(3D Reconstructions)に関する研究であるScanNetについて、全2回で確認します。

[1702.04405] ScanNet: Richly-annotated 3D Reconstructions of Indoor Scenes

#1ではAbstractとIntroductionを確認し、論文の概要を把握しました。

#2ではSection2のPrevious Work以降の主要な内容についてご紹介します。(Section6のConclusionは省略します。)

以下、目次になります。

1. Previous Work(Section2)

2. Dataset Acquisition Framework(Section3)

2-1. RGB-D Scanning(Section3-1)

2-2. Surface Reconstruction(Section3-2)

2-3. Semantic Annotation(Section3-3)

3. ScanNet Dataset(Section4)

4. Tasks and Benchmarks(Section5)

5. まとめ

1. Previous Work(Section2)

1節ではSection2のPrevious Workの内容を取り扱います。

第一パラグラフの記載では、これまでのRGB-Dデータセットやベンチマークなどの研究について紹介されています。また、これらを用いてsemantic segmentationや3D object detectionなどのタスクに対して学習を行なったことについても言及されています。

第二、第三パラグラフでは、研究例についていくつか紹介されています。例として挙がっている研究は他でも言及があることが多いので、ざっくり抑えておくのが良さそうです。第四、第五パラグラフの記載はここでは省略します。

第六パラグラフではScanNetの研究に近しい文脈(context)として、SceneNNやPiGraphsが挙げられています。また、違いとしてはSceneNNやPiGraphsが熟練者がアノテーションをつける必要があるのに対して、ScanNetでは簡易化することでクラウドソーシングなどを用いてアノテーションを行うことが可能になり、その分規模の大きな学習が可能になったとしています。

2. Dataset Acquisition Framework(Section3)

2節ではSection3のDataset Acquisition Frameworkについて確認します。

冒頭部の記載ではSection3のテーマであるScanNetデータセットの取得にあたってのフレームワークの設計について言及されています。

Introductionのところでも確認しましたが、上記のFig.2が参照されています。一連の作業の流れの概要が書かれていると認識して良さそうです。また、この記述以後のSection3はSection3-1のRGB-D Scanning、Section3-2のSurface Reconstruction、Section3-3のSemantic Annotationで構成されており、これはそれぞれFig.2の左(Left)、真ん中(Mid)、右(Right)に対応しています。以下、それぞれについて確認していきます。

2-1. RGB-D Scanning(Section3-1)

2-1節ではSection3-1のRGB-D Scanningについて確認します。

まず、Hardware面については、一般的なデバイスを用いて行うにあたってKinectセンサーをiPhoneやiPadにつけてScanを行うことについて記載されています。

次に、測定器の値の正確性を実現するにあたっての較正(calibration)については、研究室などで行う場合は観測状況(lab conditions)を制御することで実現する一方で、それだと初心者にとって実現可能なものにならないので、平らな場所に置くなどの簡易的な観測状況のみを用いるとしています。

UIについてはiOSのアプリケーションに基づいているとされています。

スキャンした結果の保持に関してはデバイスに保持することで、インターネット接続が必ずしも必要でないようにしていると記載されています。

2-2. Surface Reconstruction(Section3-2)

2-2節ではSection3-2のSurface Reconstructionについて確認します。

iPadなどのデバイスからサーバーにスキャン結果がアップロードされたのちに、表面再構成(Surface Reconstruction)を行うとされています。表面再構成はセンサーでスキャンした結果を3Dによって再構成することだとざっくり把握しておいて良いと思います。

表面再構成にあたっては、volumetric fusionという研究の手法を踏襲していると記述されており、この手法がRGB-Dデータの処理ではよく用いられている手法であるとされています。

2-3. Semantic Annotation(Section3-3)

2-3節ではSection3-3のSemantic Annotationについて確認します。

サーバーで再構成(reconstruction)処理を行なったのちに、人手でのアノテーション(annotations Human Intelligence Tasks)を行うとされています。アノテーションは主に、1)インスタンスレベルでのカテゴリラベル付け、2)3D CADのmodel alignment、の二つあるとされています。Fig.2の図と基本的には対応しているので、詳細についてはここでは省略します。

3. ScanNet Dataset(Section4)

3節ではSection4のScanNet Datasetについて確認します。

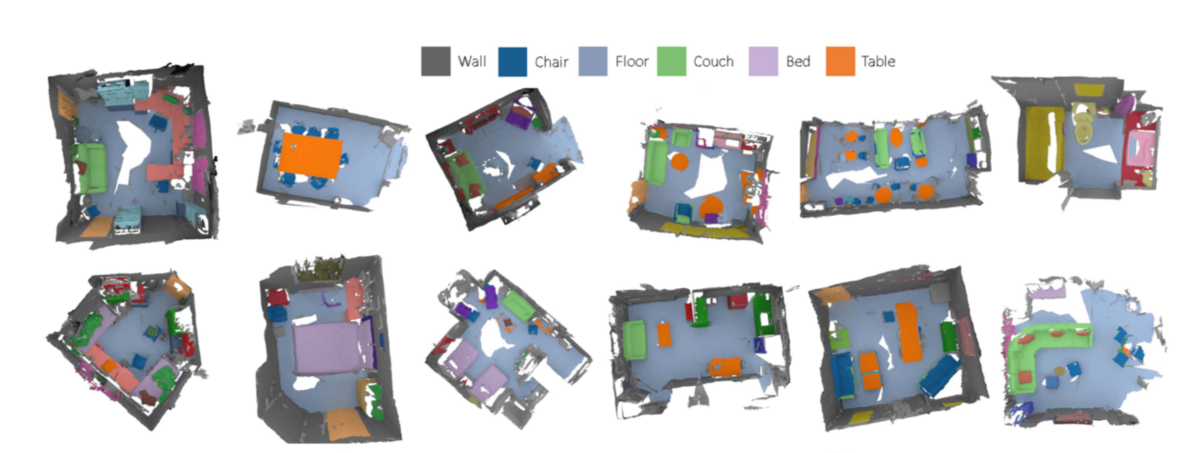

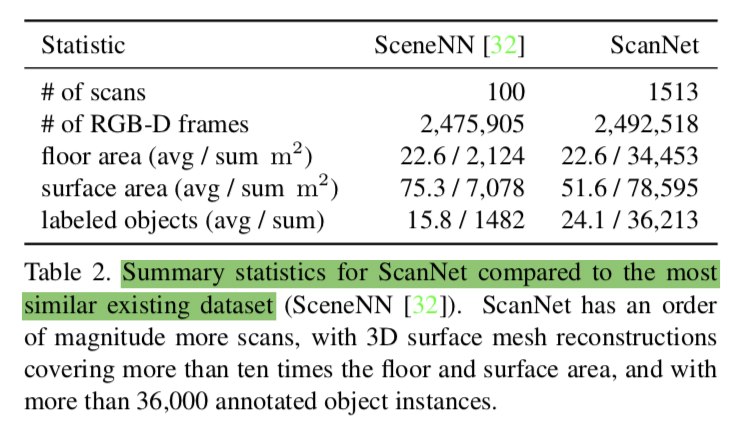

上記のTable2ではSceneNNとScanNetの比較が行われています。

また、上記のFigure5ではスキャンしたシーンについてのヒストグラムが図示されています。合計が1513として合っていそうです。

4. Tasks and Benchmarks(Section5)

ここまでで大体の内容は確認できたので、今回は省略します。

5. まとめ

#1と#2でScanNetやその研究の背景やContributionsについて確認を行いました。

関連の研究としては3Dモデリングなどが出てくると思うのでそちらの確認や、今回表面再構成(Surface Reconstruction)に用いられたvolumetric fusionについては一度確認しておくと良さそうなので機会があれば確認してみたいと思います。