ScanNetを把握する①(Abstract&Introduction) #1

3D再現(3D Reconstructions)に関する研究であるScanNetについて、全2回で確認します。

[1702.04405] ScanNet: Richly-annotated 3D Reconstructions of Indoor Scenes

#1ではAbstractとIntroductionを確認し、論文の概要を把握します。

以下、目次になります。

1. Abstractの確認

2. Introductionの確認

3. まとめ

1. Abstractの確認

1節ではAbstractの内容を確認しながら概要について把握します。以下各文の和訳とともに解説を行います。

A key requirement for leveraging supervised deep learning methods is the availability of large, labeled datasets. Unfortunately, in the context of RGB-D scene understanding, very little data is available -- current datasets cover a small range of scene views and have limited semantic annotations.

和訳:『教師ありのDeepLearningの(学習)手法をレバレッジさせるにあたっては、規模が大きくてラベル付けされたデータセットが必要になってくる。残念ながら、RGB-Dのシーン理解の文脈においては利用可能なデータが少なく、既存のデータセットは小さい範囲のシーンと限られたアノテーションしかない。』

解説:『DeepLearningを用いた画像の成功がある一方で、論文が書かれた2017年の段階ではRGB-Dのシーン理解にあたってはDeepLearningの学習に必要なデータセットが限られた数しかないことについて言及しています。』

To address this issue, we introduce ScanNet, an RGB-D video dataset containing 2.5M views in 1513 scenes annotated with 3D camera poses, surface reconstructions, and semantic segmentations.

和訳:『この課題に取り組むにあたって、我々はScanNetを提案する。ScanNetはRGB-Dの映像のデータセットで1,513シーンにおける250万のviewで、3Dカメラのポーズやsurface reconstraction、semantic segmentationsのアノテーションがつけられている。』

解説:『前述の内容を受けて、この研究ではScanNetを提案し、データセットやアノテーションを提供したとあります。』

To collect this data, we designed an easy-to-use and scalable RGB-D capture system that includes automated surface reconstruction and crowdsourced semantic annotation.

和訳:『このデータを集めるにあたって、我々は自動かsurface reconstractionとクラウドソーシングを用いたsemantic annotationを含む、簡単に使えてスケール可能なRGB-Dのキャプチャリングシステムを設計した。』

解説:『人手のアノテーションなども含んだ形でシステムを構築したとあります。この辺の詳細については本文を確認した方が早いのでここでは流して良いかと思います。』

We show that using this data helps achieve state-of-the-art performance on several 3D scene understanding tasks, including 3D object classification, semantic voxel labeling, and CAD model retrieval.

和訳:『このデータを用いることで3D object classificationやsemantic voxel labeling、CAD model retrievalを含むいくつかの3Dシーン理解のタスクに置いてSotAを達成することができることを我々は示した。』

解説:『ScanNetで提案しているデータを用いることで様々な関連タスクでSotAを達成するに至ったことについて言及されています。』

2. Introductionの確認

2節ではパラグラフ単位でIntroductionの確認を行っていきます。

第一パラグラフでは、研究の背景について記載されています。Kinectなどの3Dセンサーが発達してきている一方で、3D再現(3D reconstruction)のアルゴリズムは注目され始めた段階であることについて言及されています。この3D再現にあたって、2Dの画像のデータセットのように3Dもデータセットが必要であると記載されています。また2Dに関連して記載されている、17、44、47の参照はそれぞれPascalVOC、ImageNet、COCOを参照しているので同様の文脈で考えておくのが良さそうです。

第二パラグラフでは、多大な取り組みがなされている一方で3Dのデータセットが少ない理由について言及されています。アノテーションの難しさについて挙げられており、ポリゴンや2.5DのRGB-D画像を用いた研究や直接3Dのアノテーションを行う方法などについて記載されています。直接3Dのアノテーションを行う手法では熟練者が手動でラベル付けをする必要があり、サイズやスケール性に制限を与えているとしています。

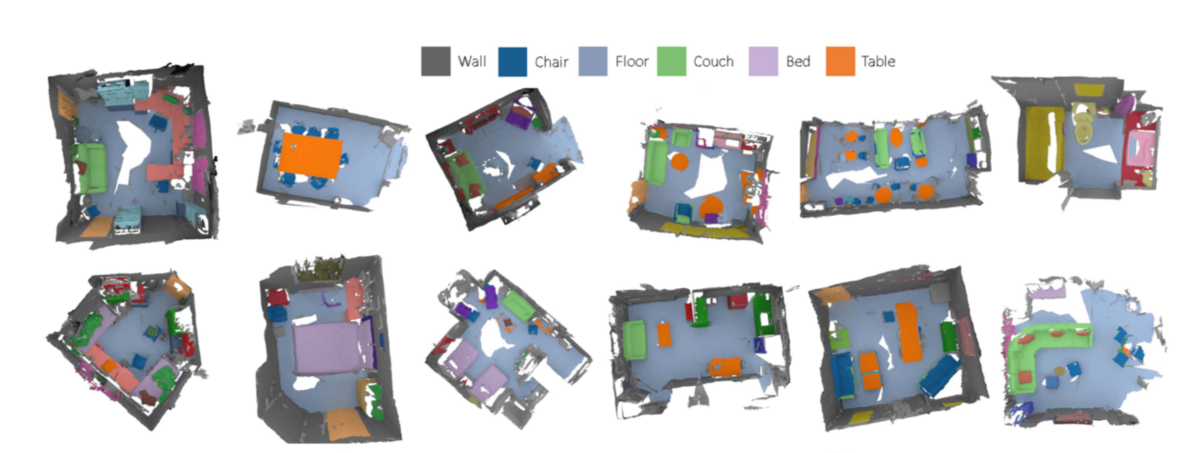

第三パラグラフでは、第二パラグラフまでの内容を受けて、この論文の主題であるScanNetについて紹介しています。ScanNetはこれまでのデータセットよりも規模の大きなデータセットになっていると記載されています。

また、Fig.2で全体の処理の流れについて記載されています。本文中の記載と図を見比べることでそれぞれの言葉の意味がつかめると思います。

第四パラグラフでは、研究にあたって生じた二つの疑問について言及しています。それぞれ、1)多くの人がアノテーションできるようなフレームワークを設計することができるのか、2)ScanNetによって提供された多くのデータとアノテーションを用いてシーン理解(scene understanding)の学習を向上させることができるのか、の2点が挙げられています。

第五パラグラフでは、1つ目の疑問であるアノテーションのフレームワークについて記載がされています。iPadなどを用いた処理の流れ(capture pipeline)を構築することについて言及されています。

第六パラグラフでは、2つ目の疑問である、ScanNetによって提供されたデータを用いて3DのDeepLearningが向上できるのかという話に対し、新しいvolumetricな(体積的な)CNNのアーキテクチャを構築したと記載されています。

第七パラグラフでは、この論文におけるcontributionsについてまとめられています。データセット、アノテーションシステム、ベンチマークなどが挙げられています。

3. まとめ

#1ではScanNetのAbstractとIntroductionの内容を元に論文の概要について掴みました。

#2では論文のSection2以降から主要なポイントに絞って内容を確認します。