XLNet①(論文のAbstractの確認)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #9

言語処理へのDeepLearningの導入をご紹介するにあたって、#3〜#8においては、Transformer[2017]やBERT[2018]について取り扱ってきました。

言語処理における事前学習(Pre-training)とBERT|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #3 - lib-arts’s diary

Attentionメカニズムと記憶ネットワーク|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #4 - lib-arts’s diary

AttentionメカニズムとTransformer|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #5 - lib-arts’s diary

BERTリポジトリのサンプル実行の流れ|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #6 - lib-arts’s diary

BERTはGLUEベンチマークを中心とする11のタスクでSOTAを達成し、事前学習(pre-trained)モデルとして大きな注目を浴びましたが、2019年6月に公開されたXLNetはBERTのパフォーマンスを上回ったと話題なので、#9ではXLNetについて取り扱えればと思います。

[1906.08237] XLNet: Generalized Autoregressive Pretraining for Language Understanding

上記の論文の情報をベースにBERTとの対比を通して内容の解説をしていければと思います。

以下目次になります。

1. XLNetの概要の把握(Abstractの把握)

2. まとめ

1. XLNetの概要の把握(Abstractの把握)

1節ではXLNetの概要の把握を行います。概要を掴むにあたっては、論文の重要な点は基本的にAbstractに記載されているのでAbstractを確認していきます。

[1906.08237] XLNet: Generalized Autoregressive Pretraining for Language Understanding

上記を元に1文ずつ和訳と解説を行なっていきます。

With the capability of modeling bidirectional contexts, denoising autoencodingbased pretraining like BERT achieves better performance than pretraining approaches based on autoregressive language modeling.

和訳:『双方向性の文脈のモデリングのキャパシティによって、BERTのようなノイズ除去自動符号化(DAE;denoising autoencoding)の事前学習は自己相関(AutoRegressive)を用いた言語モデルに基づく事前学習のアプローチよりも良いパフォーマンスを実現した』

一文目は言語処理分野においてBERT[2018]が事前学習(pretrained)モデルとして高いパフォーマンスを実現したということが言及されています。ここでAutoRegressiveとAutoEncoding(bidirectional)が対比的に使われていることに注意で、AutoRegressiveは時系列モデルなどで用いられるARモデルのニュアンスに近いです。

However, relying on corrupting the input with masks, BERT neglects dependency between the masked positions and suffers from a pretrain-finetune discrepancy.

和訳:『しかしながら、マスク化された有害な入力に依存することで、BERTはマスク化された位置と事前学習と転移学習の食い違いからくる困難の間の依存性を無視してしまっている』

二文目では一文目で言及したBERTの欠点について論じられています。DeepLearning系の論文の論理展開の流れとしては、先行研究の成功->先行研究の欠点->提案手法の流れで話が進むことが多いので、同様の流れであるという認識で大丈夫です。

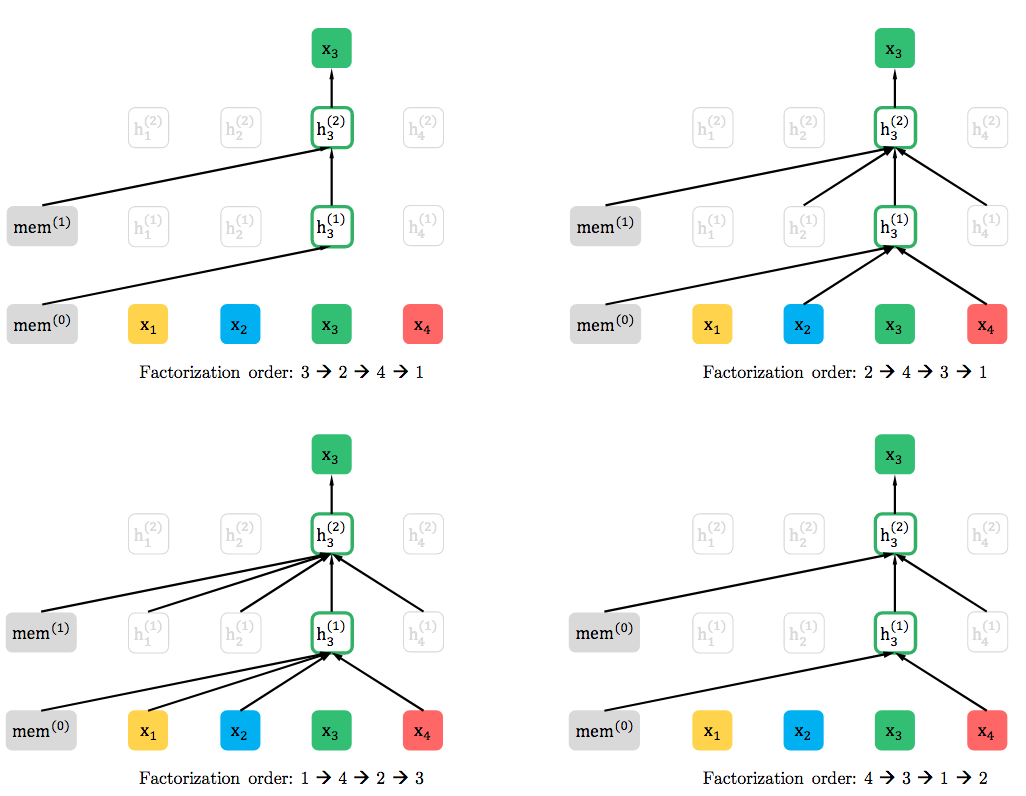

In light of these pros and cons, we propose XLNet, a generalized autoregressive pretraining method that (1) enables learning bidirectional contexts by maximizing the expected likelihood over all permutations of the factorization order and (2) overcomes the limitations of BERT thanks to its autoregressive formulation.

和訳:『この賛否両論を受けて、我々はXLNetを提案する。XLNetは一般化された自己相関(AutoRegressive)を持つ事前学習(pretraining)手法で、(1)全ての組み合わせに対する尤度を最大化することによって双方向性の文脈の学習が可能で、(2)このAutoRegressiveな式定義のおかげでBERTの限界を上回る。』

三文目ではBERTの欠点として言及された事前学習の際のマスク化を解消するためにXLNetに関して提案されています。

Furthermore, XLNet integrates ideas from Transformer-XL, the state-of-the-art autoregressive model, into pretraining.

和訳:『さらに、XLNetはTransformer-XLのアイデアを統合し、事前学習に置いてSOTAを実現するAutoRegressiveモデルとなった。』

Transformer-XLのアイデアの統合について触れられています。

Empirically, XLNet outperforms BERT on 20 tasks, often by a large margin, and achieves state-of-the-art results on 18 tasks including question answering, natural language inference, sentiment analysis, and document ranking.

和訳:『総括としては、XLNetは20のタスクでBERTを上回り、しばしば大きな差をつけている。また、質問応答(QA; Question Answering)、自然言語推論、極性分析、文書のランクづけなど18のタスクでSOTAの結果を実現した。』

五文目ではXLNetの実験結果(パフォーマンス)についてまとめられています。

上記で大体の概要はつかめたので1節はここまでとします。

2. まとめ

今回はXLNetの論文のAbstractを確認しながら概要について掴みました。

実際の中身については#10以降で取り扱っていきます。

↓また、当記事のシリーズの内容を元に再構成と少しだけ加筆を行い電子書籍化を行いました!pdf版が欲しいなどありましたら下記をご購入いただけたら大変嬉しいです!!