CTRL: A Conditional Transformer Language Model for Controllable Generation③(Source Attribution以降)|言語処理へのDeepLearningの導入の研究トレンドを俯瞰する #44

言語処理へのDeepLearningの導入をご紹介するにあたって、#3〜#8においては、Transformer[2017]やBERT[2018]について、#9~#10ではXLNet[2019]について、#11~#12ではTransformer-XL[2019]について、#13~#17ではRoBERTa[2019]について、#18~#20ではWord2Vec[2013]について、#21~#24ではALBERT[2019]について、#26〜#30ではT5[2019]について、#31〜#32ではERNIEについて、#33〜#34ではELMo[2018]について、#35〜#36ではself-attention、#37〜#38ではDecomposable Attentionについて、#39〜#41ではReformer[2020]について取り扱ってきました。

#42以降では条件付きのTransformerを用いることで、生成の制御を行うCTRL(Conditional TRansformer Language Model)に関する下記の論文を取り扱っていきます。

[1909.05858] CTRL: A Conditional Transformer Language Model for Controllable Generation

#42ではAbstractとIntroductionについて、#43ではSection2のLanguage ModelingからSection4のControllable Generationまでを取り扱いました。

https://lib-arts.hatenablog.com/entry/nlp_dl42

https://lib-arts.hatenablog.com/entry/nlp_dl43

#44ではSection5のSource Attribution以降について取り扱っていきます。

以下目次になります。

1. Source Attribution(Section5)

2. Related Work(Section6)

3. Future Directions(Section7)

4. CTRL-ALT-DEL(Section8)

5. Conclusion(Section9)

6. まとめ

1. Source Attribution(Section5)

1節ではSection5のSource Attributionについて取り扱います。

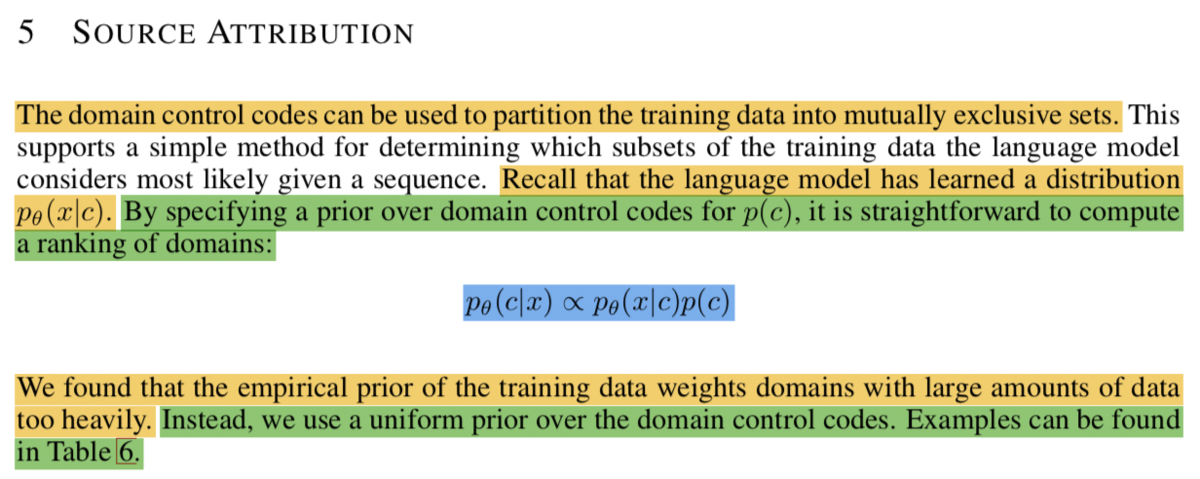

上記ではドメインの制御コード(domain control codes)を、ベイズの定理を用いて考察を行なっています。言語モデルはを学習しているとされており、ここに事前分布の

を与えるなどについて記載されています。(数式が少ないなどいまいち記述が明瞭ではない印象を受けました。)

2. Related Work(Section6)

2節ではSection6のRelated Workについて取り扱います。Related Workでは、"Language modeling"、"Multi-task learning"、"Sampling methods and coverage mechanisms"の三つについて取り扱われています。

Language modelingではBengioのLanguage model[2003]やWord2vec[2013]やTransformer[2017]などについて紹介されています。近年ではBERT[2018]などの事前学習モデル(pretrained model)などが研究トピックの中心になっています。

残り二つについては省略します。

3. Future Directions(Section7)

3節ではSection7のFuture Directions(将来研究の方向性)について取り扱います。

"More control codes and finer-grained control"ですが、CTRLの論文ではdomain、topic、entity relations、日付など様々な属性に対して取り扱われてきましたが、将来研究ではさらに様々なドメインにおける拡張を行うことを望むとされています。

その他については省略します。

4. CTRL-ALT-DEL(Section8)

5. Conclusion(Section9)

今回は省略します。

6. まとめ

#44ではCTRLの論文のSection5のSource Attribution以降について取り扱いました。

#45以降では下記などを参考にALBERTの実装について確認していきます。